3.3.1. Fundamentals#

3.3.1.1. Overview of DeepLearning#

1. DL good for ?

Problem with long list of rules/features

Continually changing model/prediction

Discovering insights within large collection of data

2. DL not good for ?

Need explainability model

traditional model is the good option

when errors are not unacceptable

when you don’t have much data

3. ML vs DL

ML thường phục vụ structured data và có perform tốt hơn so với DL với dữ liệu này, còn DL performs better on unstructured data such as images, voice, text,…

Các thuật toán:

ML: RF, naive bayes, nn, svm,…

DL: NN, CNN, RNN

4. DL use case

Nguồn tìm kiếm các paper + code của các model SOTA theo từng task tại papers with code

Recommendation

Sequence to sequency:

Translation

Speed recognition

Classification/ Regression:

Computer vision

NLP

3.3.1.1.1. Những lỗi khi huấn luyện mạng#

3.3.1.1.1.1. Không hiểu cách hoạt động#

Mặc dù các thư viện cung cấp các API giúp việc xây dựng và train model trở nên thuận tiện, nhưng nếu chúng ta ko hiểu cách hoạt động của chúng ( ví dụ : không biết sự khác biệt giữa SGD và Adam ) thì rất khó có cơ sở để lựa chọn phương pháp sao cho phù hợp với vấn đề cần giải quyết, từ đó tiến đến sự ổn định và hiệu quả của model.

Tóm gọn lại, trước khi sử dụng bất kỳ một thứ gì trong quá trình train, mặc dù ta sử dụng API nên rất dễ dàng trong việc áp dụng nhưng phải hiểu được bản chất của phương pháp, ưu và nhược điểm hay các TH sử dụng của nó.

3.3.1.1.1.2. Train không đúng logic#

Mặc dù trong quá trình train đến kết quả không gặp lỗi hay biến số bất thường nào, nhưng vẫn có thể sai về mặt logic trong quá trình biến đổi dữ liệu.

Ví dụ: Thay vì hạn chế tác động của gradient lớn thì lại làm giảm loss, nguyên nhân là do outlier bị loại bỏ

Từ đó dẫn tới việc, model train ko ra lỗi, nhưng càng train thì performance càng tệ đi.

3.3.1.1.2. Kinh nghiệm train NN#

Kinh nghiệm chung là với mỗi vấn đề cần phải thử, thí nghiệm cho tới khi đạt được hiệu quả hoặc hiểu rõ vấn đề, rồi mới giải quyết vấn đề tiếp theo thay vì 1 lần đem một đống thứ cần thử và không thể biết hướng đi nào cần cải tiến tiếp theo.

Kinh nghiệm modeling theo quá trình build model:

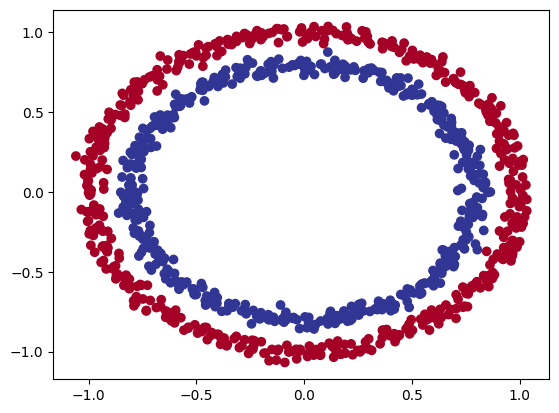

3.3.1.1.2.1. Hiểu rõ data#

Thay vì sử dụng ngay các dòng code xây dựng mạng NN thì việc đầu tiên nên làm đó là hiểu thật kỹ về data:

Hiểu sample: variance, distribution, tìm kiếm những pattern đại diện trong data

Sự imbalance data

Những sample outlier

Tính tương quan của dữ liệu

Thêm vào đó, cần tracking được lý do các dự đoán sai từ model, từ đó đưa ra được hướng cải thiện

3.3.1.1.2.2. Thiết lập 1 quy trình xây dựng và đánh giá model#

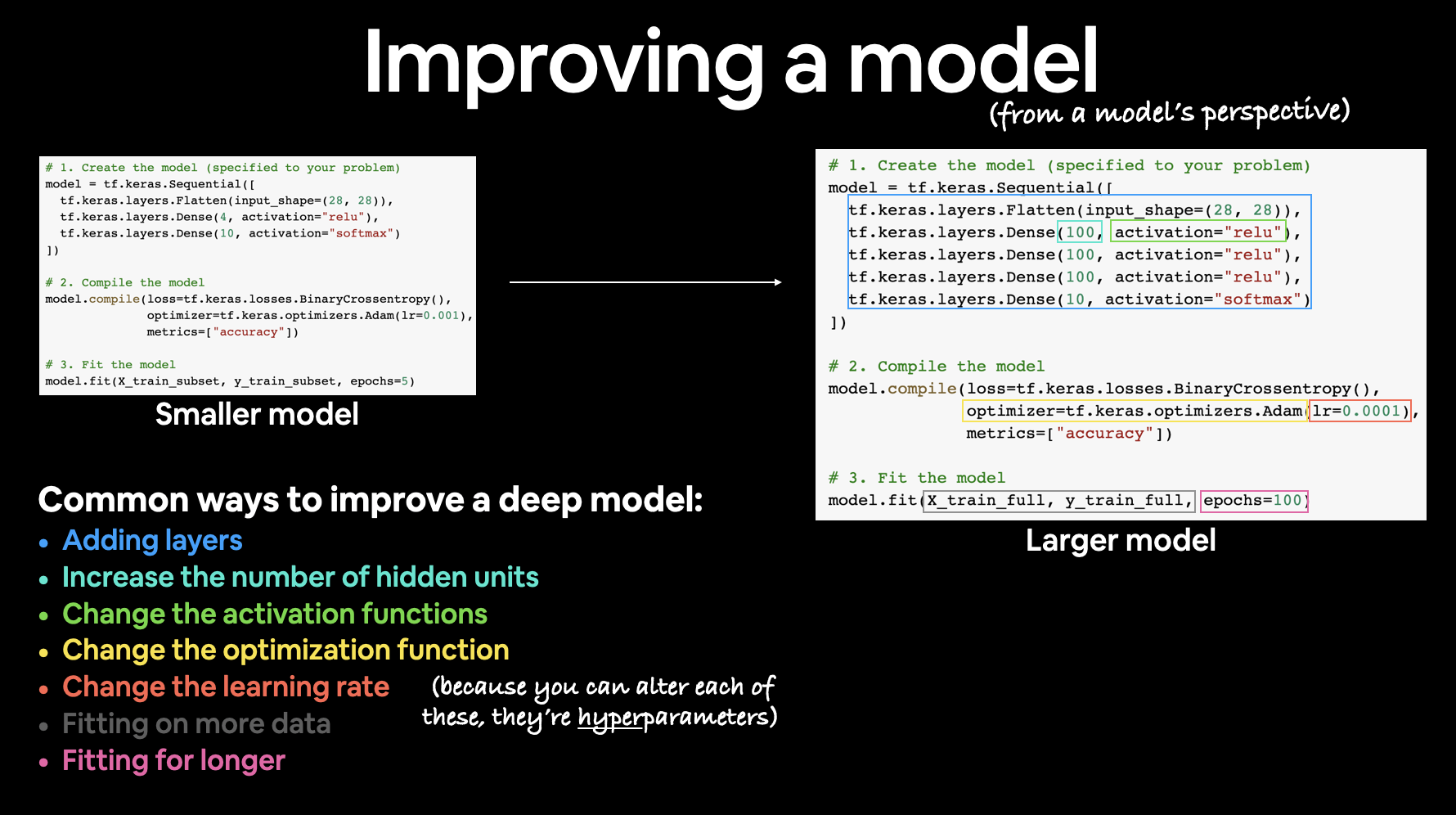

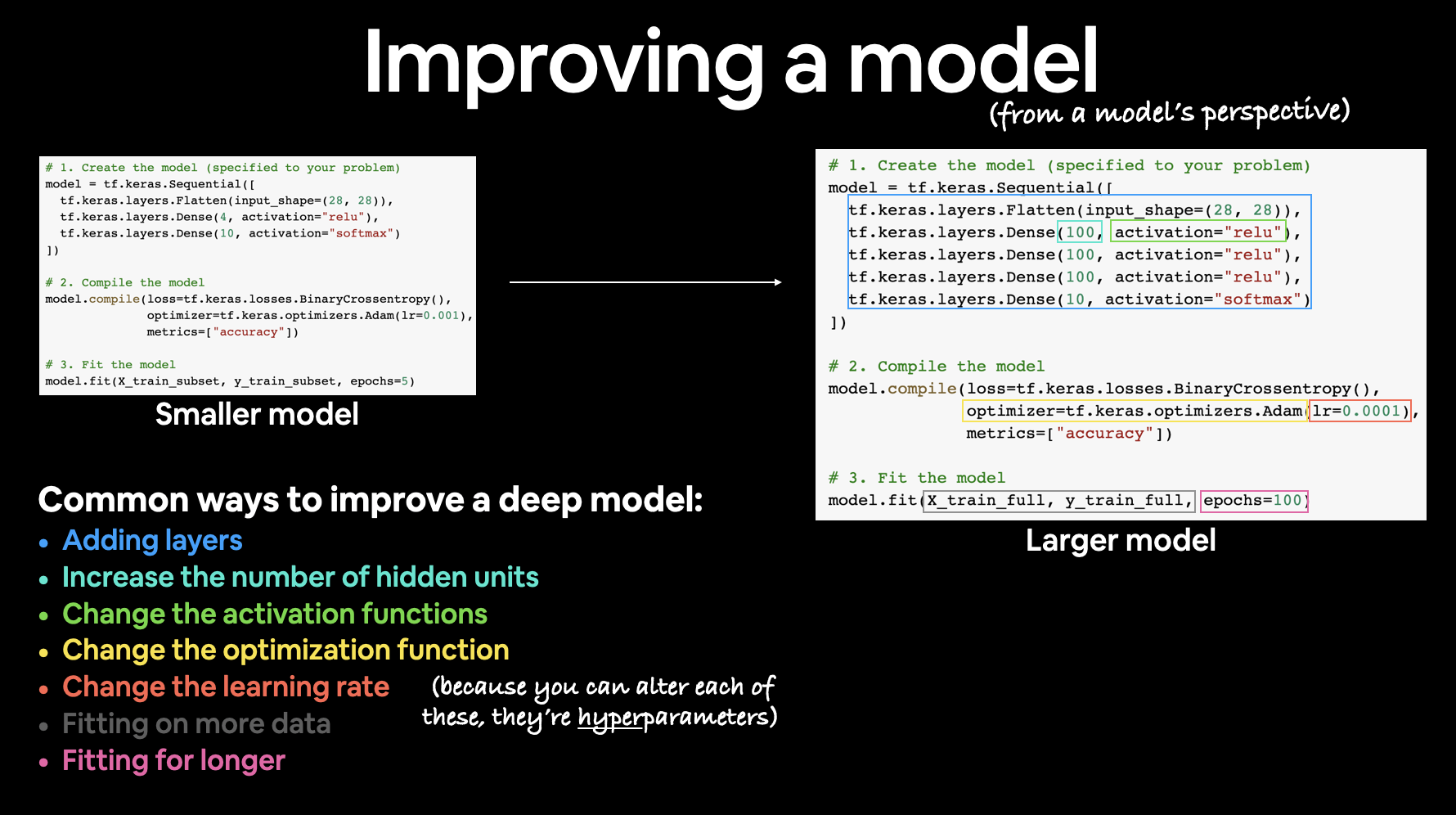

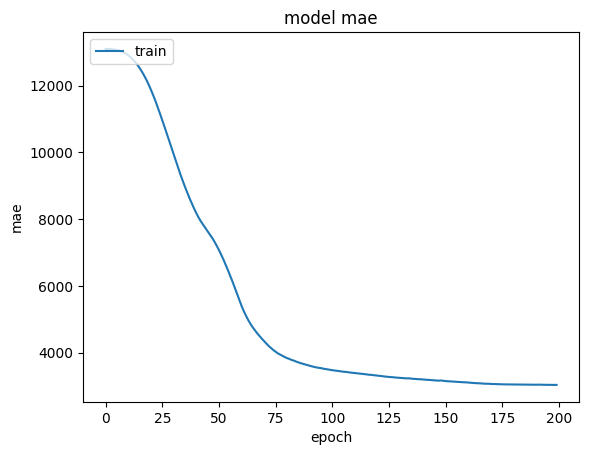

Ban đầu hãy xây dựng 1 baseline model từ bước tạo model, comppile, fitting, evaluate model thành 1 quy trình có khung sườn. Sử dụng các đánh giá và thí nghiệm thay đổi các hyperparameters để quan sát sự cải thiện của model dần dần. Các tips cho việc này bao gồm:

Tạo baseline model có thể là những model đơn giản nhất hoặc mạng nn đơn giản nhất

Sử dụng cố định random seed

Đơn giản hoá cho model ban đầu: loại bỏ data augmentation vì học tăng cường lại dữ liệu chỉ là 1 chiến lược regularization sau này, ở bước ban đầu nên hạn chế để tránh gặp các lỗi ko cần thiết. Ví dụ : xoay ảnh, lật ảnh chính là học tăng cường

Xây dựng các bộ đánh giá trên đầy đủ các khía cạnh để đảm bảo tính hiệu quả và chất lượng của model

Xác định đúng Loss function ngay từ thời điểm ban đầu và nhất quán sử dụng nó.

Khởi tạo tốt tham số cho layer output: xây dựng các ước lượng ban đầu tốt cho output sẽ giúp model nhanh chóng tìm được điểm tối ưu và tránh các điểm giả global minimum loss sẽ phải gặp tại các iter ban đầu trong quá trình train

Nếu trong bài toán regression, giá trị mean target là 50 thì có thể đặt giá trị bias là 50 để nhanh chóng tìm được điểm tối ưu cho bias

Nếu trong bài toán classification bị imbalance là good/bad = 9/1 thì có thể đặt giá trị cutoff probability ban đầu là tại điểm 0.9 để phù hợp với tỷ lệ good/bad ngoài thực tế.

Chú ý vào metrics thay vì loss: metrics (ví dụ như accuracy) là thứ mà có thể giải thích và có thể so sánh được giữa các model với nhau

Tạo một baseline model với dự đoán ngẫu nhiên so sánh với model học được dữ liệu xem xem model sau khi được train có học được gì từ dữ liệu hay không hay hiệu suất tương đương với random guess model

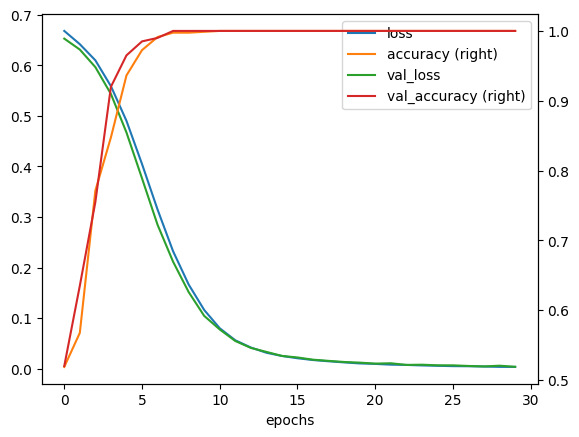

Thử overfit 1 batch với số lượng samples nhỏ ( ví dụ batch chỉ có 5 samples và overfit batch này) để lấy được giá trị minimumm loss, nếu minimum loss không tiệm cận được 0 thì có vẻ như có 1 bug ở đâu đó trong quá trình biến đổi dữ liệu (lỗi 2)

Đánh giá mức giảm của loss khi tăng độ phức tạp của model

Sử dụng dữ liệu ngay trước khi đưa vào mạng, decode ngược lại raw data để tracking tính đúng đắn của việc preprocessing và data augmentation

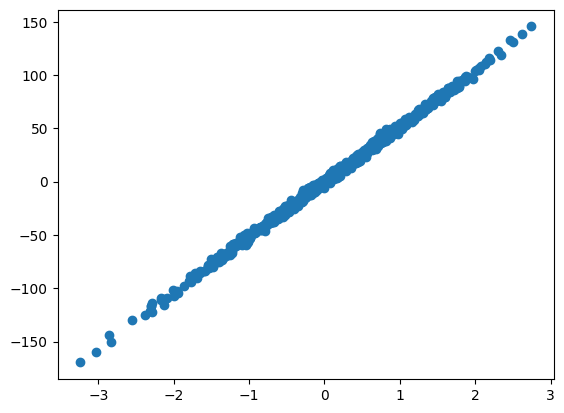

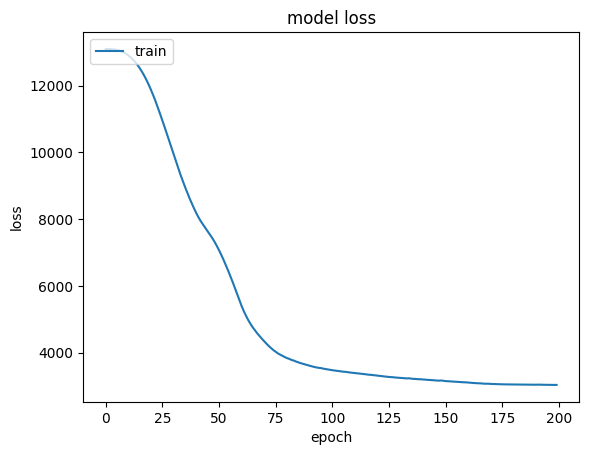

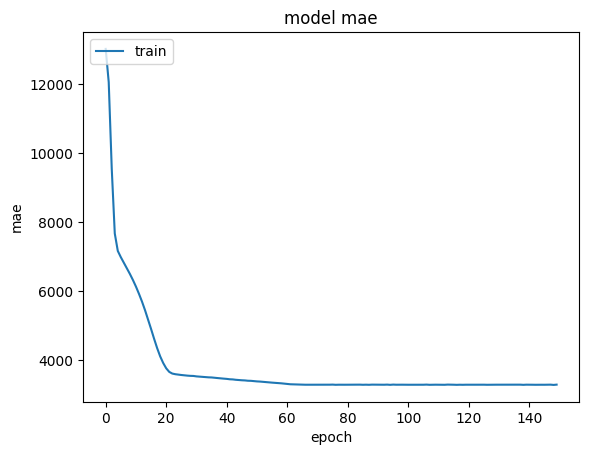

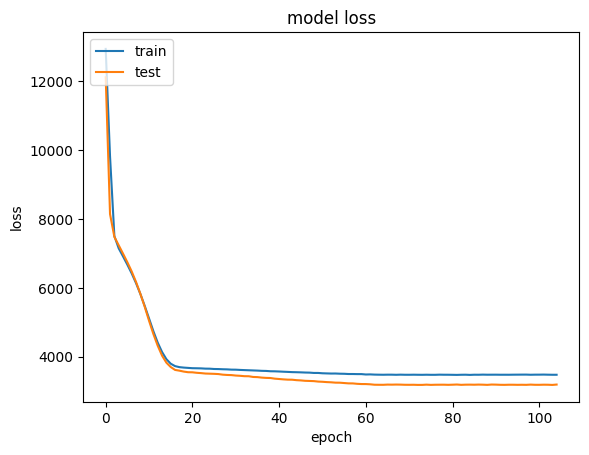

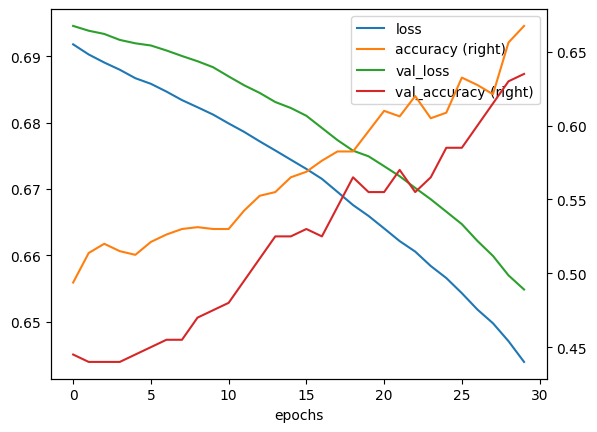

Quan sát sự thay đổi của prediction: visualize the test prediction trong suốt quá trình training để đảm bảo việc đi đúng hướng của model. Nếu hiệu suất của tập test ko cải thiện hoặc ổn định theo quá trình training thì có thể nên set một learning_rate thấp hơn để tăng sự ổn định.

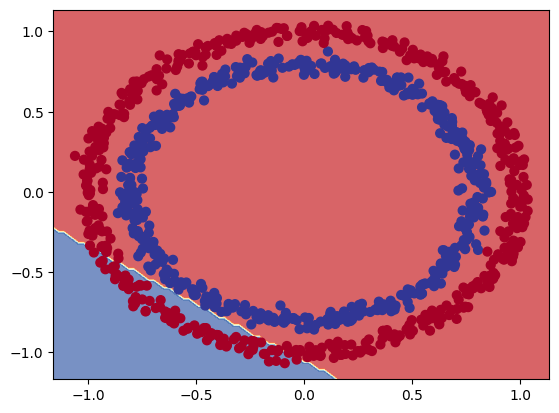

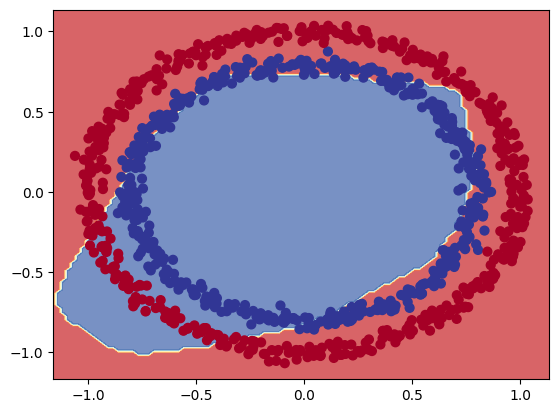

3.3.1.1.2.3. Overfitting#

Ở bước này chúng ta đã hiểu về dữ liệu và có 1 pipeline train + đánh giá hoạt động được. Việc cần làm là tìm ra 1 model tốt bằng việc tìm 1 mô hình đủ lớn để overfit (loss tập train đủ thấp) rồi sau đó regularize cho phù hợp để cải thiện val_loss.

Lý do chọn hướng tiếp cận này là nếu loss_train ko đủ thấp tức là model có thể bị lỗi, có vấn đề hoặc misconfiguration nào đó.

Một số tips:

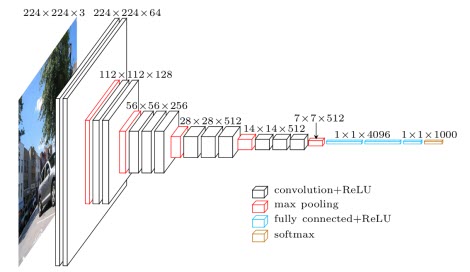

Chọn model: Để có 1 train_loss đủ thấp thì model cần có 1 architecture phù hợp với dữ liệu. Thay vì sáng tạo các kiến trúc cảm thấy sẽ hiệu quả thì hãy tìm các paper liên quan nhất và copy những kiến trúc đơn giản nhất của họ và phát triển nó.

Ví dụ nếu làm image classification, hãy copy kiến trúc mạng của ResNet-50 trước, sau đó có thể phát triển lên từ đó.

Adam là sự lựa chọn an toàn: với những baseline ban đầu, hãy ưu tiên với Adam(lr = 3e-4). Adam có thể dễ dàng bỏ qua những hyperparameter tệ (bao gồm cả learning_rate).

Với các mạng CNN, optimizer = SGD sẽ hiệu quả hơn 1 chút so với Adam, những giá trị lr tối ưu chỉ trong 1 range rất hẹp và tuỳ vào bài toán cụ thể

Với bài toán RNN, time-series thì ưu tiên Adam

Chỉ nên tunning (làm phức tạp) một yếu tố tại 1 thời điểm: hãy tunning từng parameter và đảm bảo performance được cải thiện trước khi sang hyperparameter tiếp theo

Đừng tin vào default decay-learning rate: Với mỗi bài toán và vấn đề cụ thể thì hệ số giảm của learning rate sẽ khác nhau, nếu ko cẩn thận sẽ đưa lr về 0 trong khi việc học vẫn chưa xong. Hãy sử dụng constant learning rate và tunning decay - learning rate sau cùng

3.3.1.1.2.4. Regularization#

Sau khi đã có một model đủ tốt trên tập train với train_loss đủ thấp thì chúng ta cần regularize để cải thiện độ chính xác của validation set ( đương nhiên là sẽ giảm hiệu xuất của train set), một số phương pháp giúp regularize:

Lấy thêm dữ liệu : Đây là cách tốt nhất và được khuyến khích nhất để regularize một mô hình trong bất cứ setting nào. Một sai lầm thường thấy là vắt kiệt việc học từ data train đã có mà ko bổ sung thêm dữ liệu sẵn có mới bên ngoài mà có thể thu thập được.

Sử dụng Emsemble model: nếu có thể thì tối đa nên sử dụng 5 model

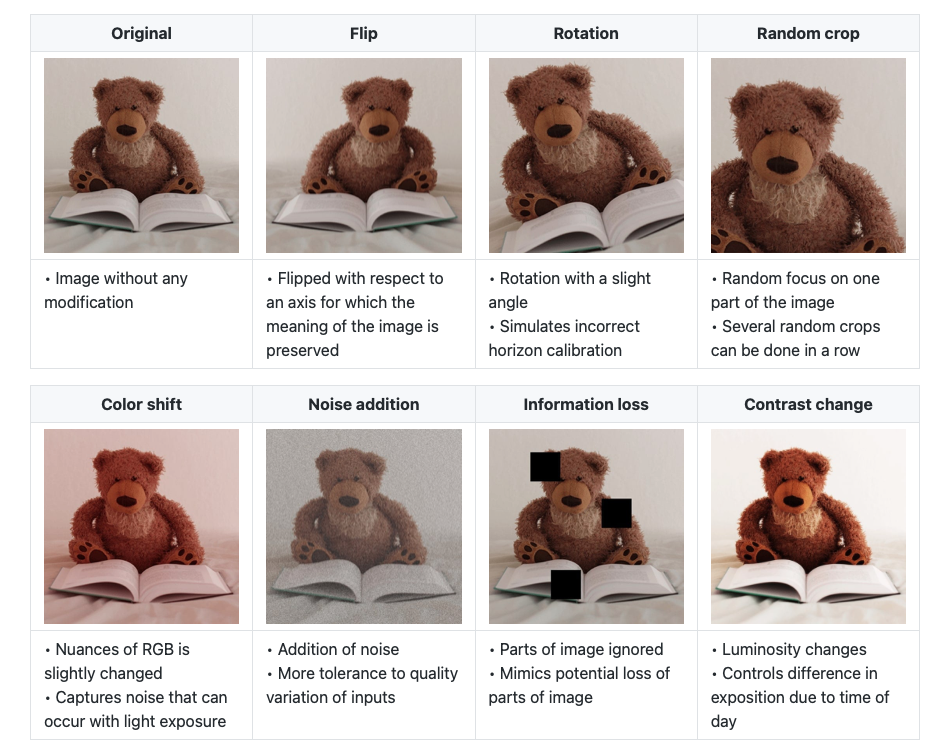

Dữ liệu tăng cường (data augmentation): Nếu ko thể lấy thêm dữ liệu thì hãy sử dụng 1 số phương pháp biến đổi dữ liệu để học tăng cường

Dữ liệu tăng cường bằng việc làm giả hoàn toàn bằng các phương pháp: tạo thêm dữ liệu xung quanh dataraw, domain randomization, use of simulation, clever hybrids such as inserting (potentially simulated) data into scenes, or even GANs.

Pretrain model: Sử dụng các model đã được pretrain sẵn bằng nguồn dữ liệu lớn đã có

Hãy bám vào supervised learning: đừng nên quá lạm dụng các model unsupervised learning

Giảm input dimensionality : loại bỏ một số đặc trưng có thể giúp bỏ đi các tín hiệu giả (các tín hiệu ko hỗ trợ trong việc dự đoán output), những redunce feature được sử dụng sẽ làm model bị overfitting. Có thể sử dụng các phương pháp làm giảm chiều dữ liệu như PCA.

Thử một model nhỏ hơn (giảm số layers/nodes): sử dụng kiến thức về dữ liệu có thể làm một cách để ràng buộc sử dụng/ hoặc ko sử dụng một số node/hay layers nào đó thay vì sử dụng fully connected layers.

Giảm batch_size: Sử dụng normalize với smaller batch sẽ tâng mức độ regularization

Sử dụng phạt L1/L2: Sử dụng L2 phạt nặng hơn L1 khi W tăng mạnh

Dropout : Thêm Dropout, bổ sung xác xuất tắt node trong layer, tuy nhiên sử dụng một cách cẩn thận, hạn chế vì có vẻ Dropout không thích chơi chung với BatchNorm

Batch Normalization: normalize batch trước khi đưa vào training

Early stopping: Bổ sung điều kiện dừng sớm epochs khi validattion_loss có xu hướng overfit. Ưu tiên sử dụng Early stopping với large model so với full-epoch + smaller model

Decay weighted: Tăng mức weight decay cho các tham số học, tăng regularization

Hãy visualize first layer output để chắc chắn những khía cạnh nó học được là hợp lý

3.3.1.1.2.5. Tune model#

muốn tìm một kiến trúc đạt được validation loss tốt nhất. Một vài tip và trick cho bước này:

random grid search. Tune một lúc nhiều hyperparameter nghe có vẻ rất hấp dẫn bằng việc grid search nhằm bao quát hết tất cả các cách thiết lập, nhưng hãy nhớ trong đầu rằng cách tốt nhất là sử dụng random search (tham khảo tại đây). Một cách trực giác, bởi vì các mạng neuron thường nhạy cảm với một vài parameter hơn những cái khác. Trong giới hạn, nếu parameter a có nhiều tác động, nhưng thay đổi parameter b không có nhiều ảnh hưởng vậy bạn nên sample parameter a nhiều hơn thay vì cố định tại 1 điểm nhiều lần.

3.3.1.1.2.6. Tận dụng hết khả năng có thể#

Một khi bạn đã tìm ra kiến trúc tốt nhất và các hyperparameter, bạn vẫn có thể sử dụng thêm 1 vài trick để tận dụng nốt các phần còn lại của hệ thống:

Có một kĩ thuật gọi là Knowledge Distillation nhằm chuyển các tri thức học từ một mô hình lớn về một mô hình nhỏ hơn

Thử train model trong 1 thời gian dài, có thể sẽ đạt SOTA

3.3.1.1.3. Good practice#

3.3.1.1.3.1. Training a NN#

3.3.1.1.3.1.1. Definitions#

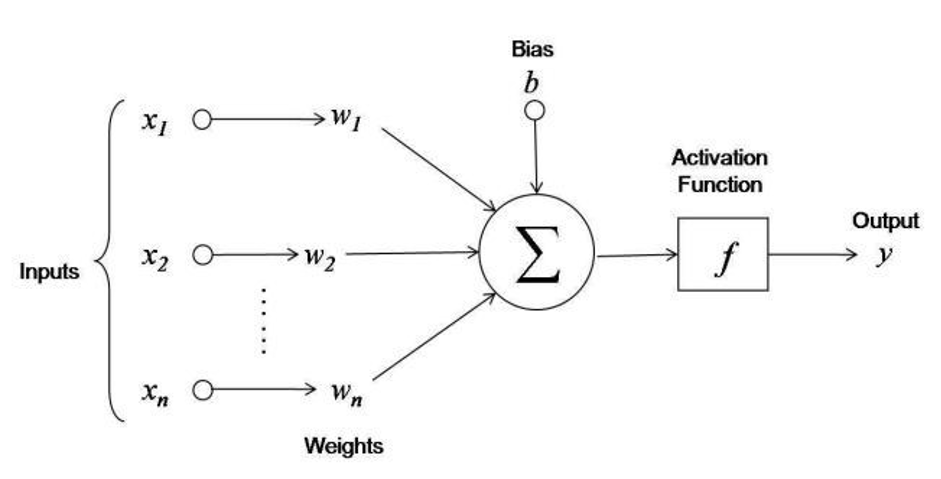

📚 Epoch: In the context of training a model, epoch is a term used to refer to one iteration where the model sees the whole training set to update its weights.

📚 Mini-batch gradient descent: During the training phase, updating weights is usually not based on the whole training set at once due to computation complexities or one data point due to noise issues. Instead, the update step is done on mini-batches, where the number of data points in a batch is a hyperparameter that we can tune.

📚 Loss function: In order to quantify how a given model performs, the loss function L is usually used to evaluate to what extent the actual outputs y are correctly predicted by the model outputs z

📚 Cross-entropy loss: In the context of binary classification in neural networks, the cross-entropy loss L(z,y) is commonly used and is defined as follows:

3.3.1.1.3.1.2. Finding optimal weights#

📚 Backpropagation: Backpropagation là method để update the weights trong neural network bằng việc sử dụng sai lệch giữa output được predict và thực tế. The derivative liên quan đến each weight

wsẽ được tính toán thông qua chain rule.

Qua đó, mỗi 1 weight sẽ được update theo công thức: $\(w \longleftarrow w-\alpha \frac{\partial L(z, y)}{\partial w}\)$

3.3.1.1.3.2. Parameter tuning#

3.3.1.1.3.2.1. Weights initialization#

📚 Xavier initialization: Thay vì lựa chọn các params/weights ban đầu 1 cách ngẫu nhiên thì khởi tạo chúng bằng những khảo sát ban đầu và có khả năng là điểm optimal gần đó.

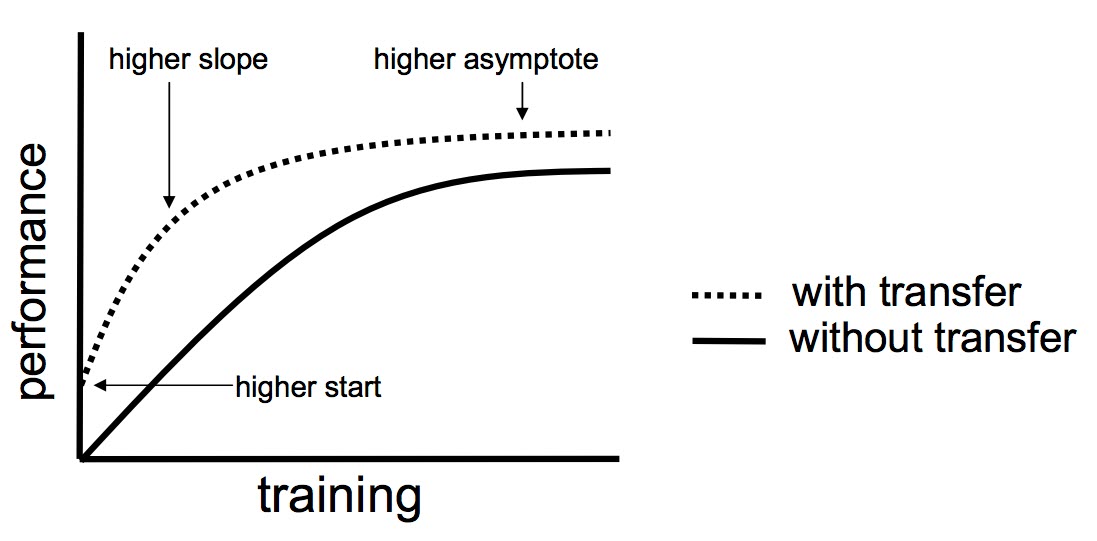

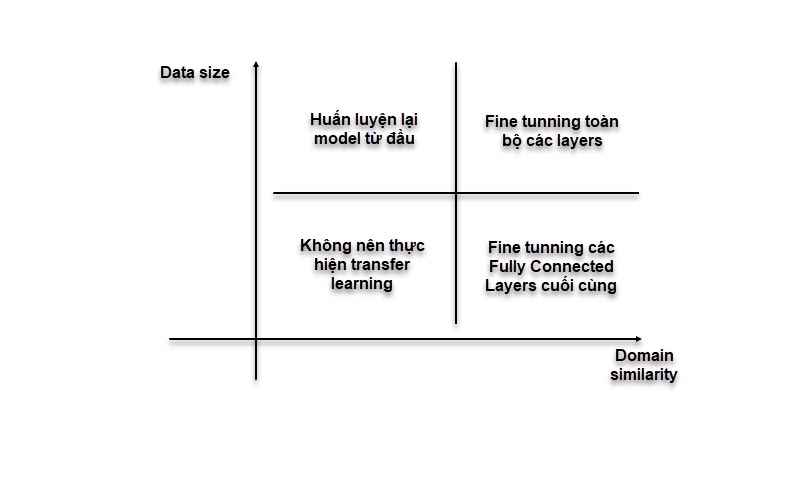

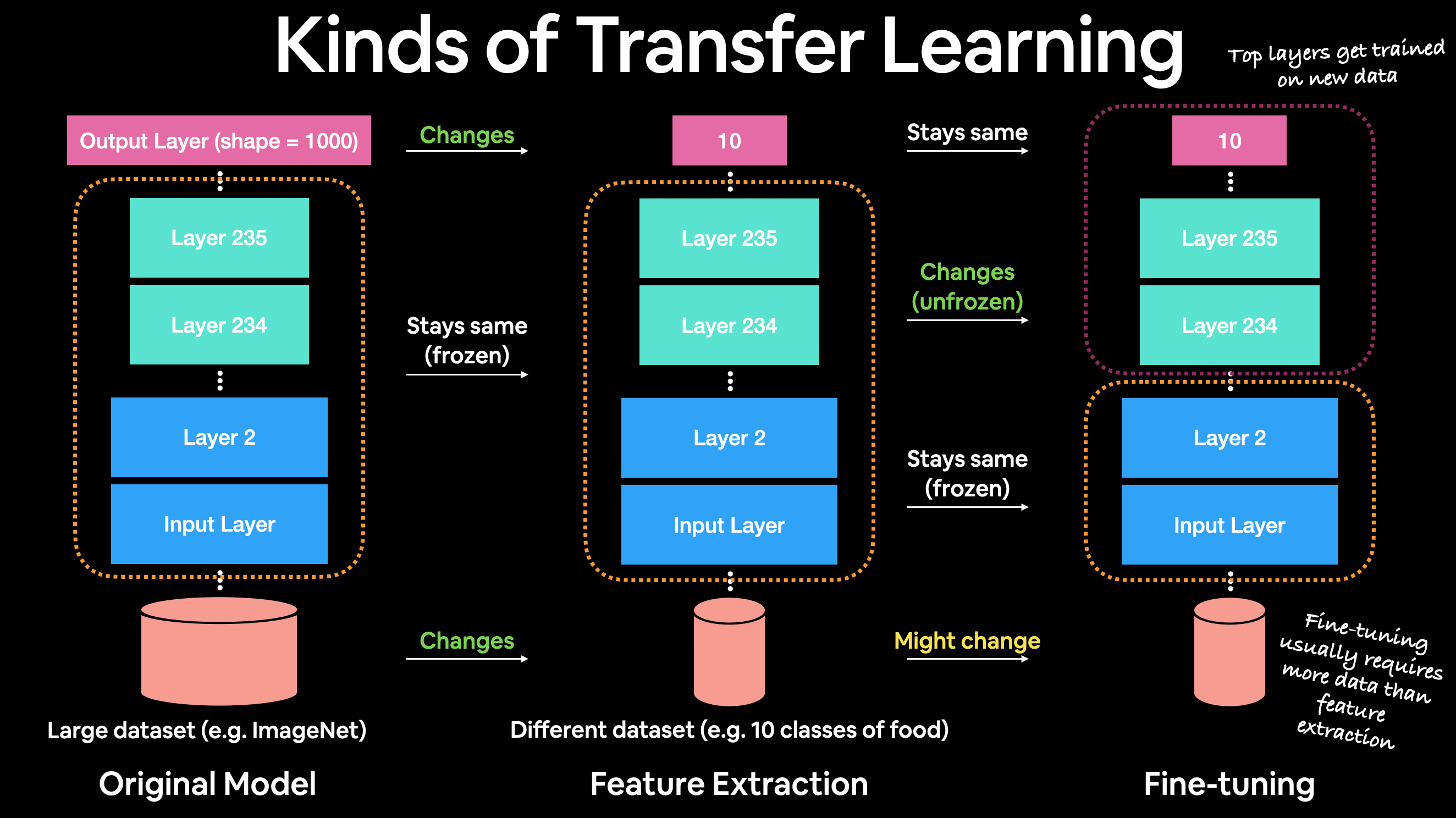

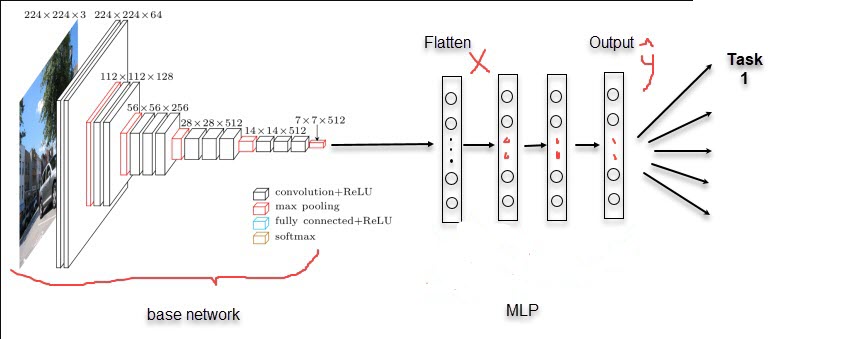

📚 Transfer learning: Các weights/params ban đầu hay thậm trí là 1 phần kiến trúc mạng đã được thiết kế từ trước và train trên các bộ dữ liệu lớn, đạt performance cao nên chỉ cần tận dụng lại.

Tips: Dữ liệu có size càng lớn thì unfreeze càng nhiều top layer của pretrain model sau khi đã train qua 1 vài epochs với feature extraction model.

3.3.1.1.3.2.2. Optimizing convergence by learning rate#

Fixed Learning rate

Schedule reduce learning rate

Adaptive learning rate

Momentum

RMSprop

Adam

3.3.1.1.3.3. Regularization#

3.3.1.1.3.4. Overfitting small batch#

Khi debugging model, thường sử dụng quick test để kiểm tra các vấn đề liên quan đến kiến trúc mạng, tham số hay những tinh chỉnh đã đúng hay chưa ? Khi đó, cần sử dụng mini-datatrain và fit cho tới khi overfit trên small batch đó. Nếu không thể overfitting trên tập nhỏ thì khả năng mô hình chưa đủ tốt hoặc sai cấu trúc

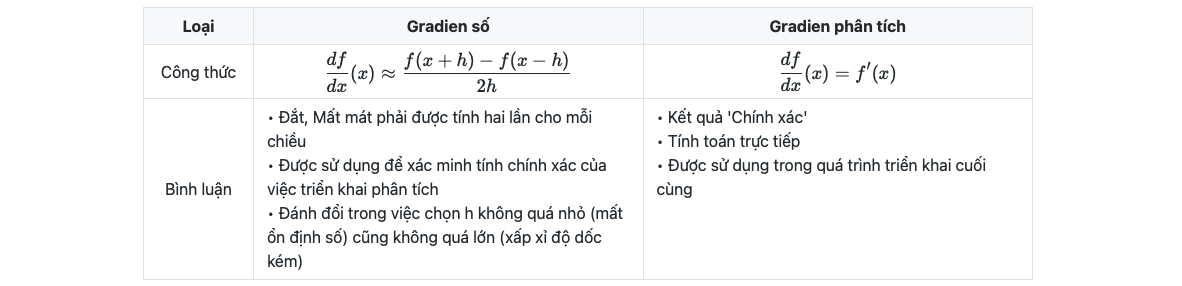

3.3.1.1.3.5. Gradient checking#

Kiểm tra gradien là một phương thức được sử dụng trong quá trình thực hiện lan truyền ngược của mạng neural. Nó so sánh giá trị của gradien phân tích (analytical gradient) với gradien số (numerical gradient) tại các điểm đã cho và đóng vai trò kiểm tra độ chính xác của hàm đạo hàm xây dựng

3.3.1.2. Gradient descent optimization#

3.3.1.2.1. Gradient descent#

1. Gradient

là 1 vector chứa đạo hàm thành phần của hàm f(x1,x2,..,xn), nhiều gradient tạo thành 1 matrix jacobian

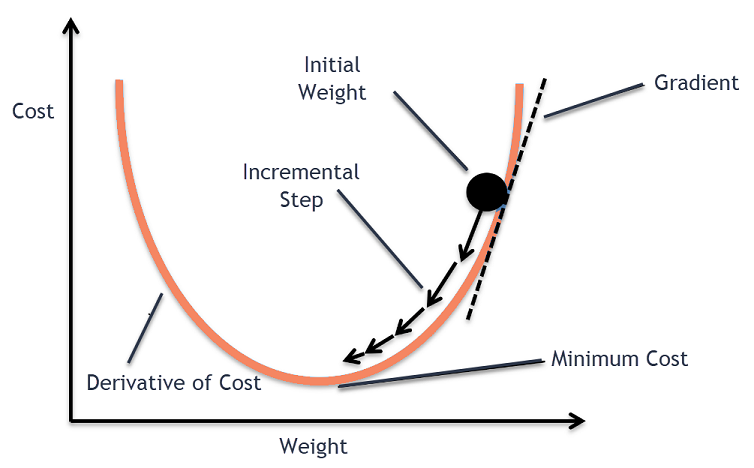

2. Gradient descent

Trong tối ưu, gradient là 1 hyperplane tiếp tuyến của f(x) tại điểm x = t, tương ứng với \(W_t\), khi đó hệ số được update theo công thức: $\(W_{t+1} = W_t - lr * gradient\)$

Thuật toán sẽ stop khi \(|W_{t+1} - W_t| <= \epsilon \)

gradient = \(\frac{\partial L}{\partial w}\) = với hệ số góc của hyperplane = đạo hàm bậc 1 của f(x) tại x=t

Learning rate (lr) sẽ tác động tới khả năng học nhanh/chậm bằng việc điều chỉnh gradient

Nếu nhiều data có thể set lr nhỏ, và ngược lại

Có thể để lr =

constanthoặc lr giảm dần theo quá trình train (\(\frac{lr}{\sqrt{t+1}}\))

3.3.1.2.2. Các loại gradient descent (GD)#

Các loại GD theo số lượng obs cho mỗi epoch train

1. Vanilla GD/ Batch GD

Update 1 lần trên toàn bộ dataset

Pros : đảm bảo hội tụ được tới GLOBAL minimum cho convex loss hoặc non-convex loss

Cons :

thuật toán chạy sẽ chậm với dữ liệu lớn,

ko đủ memory để load hết dữ liệu

không có khả năng update real-time

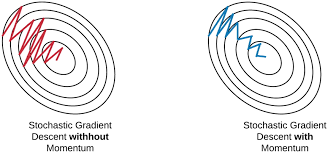

2. Stochastic gradient descent (SGD)

Update weight theo từng quan sát lần lượt trên dataset

Pros :

Không gặp vấn đề về khả năng load, tính toán nhanh

Có tính train real-time, học online

Cons :

Do học theo từng obs nên có variance cao

hướng di chuyển của hàm Loss không ổn định

Khả năng hội tụ lâu do học không ổn định hoặc đi sai hướng để tìm điểm loss tối ưu

2. Mini-batch gradient descent

Chia data thành nhiều mini batch gồm n obs và lần lượt học theo từng mini-batch. Dữ liệu được lấy random cho từng batch.

Pros :

Giảm variance của parameter update, more stable convergence

Có thể sử dụng các thuật toán tối ưu hoá matrix theo từng batch để tăng tính hiệu quả. Ví dụ như batch normalization

Cons :

Lựa chọn lr: Nếu quá nhỏ sẽ học chậm, nếu quá lớn thì loss sẽ giao động quanh điểm hội tụ hoặc thậm trí đi qua điểm tối ưu

Chưa giải quyết được vấn đề saddle point

3.3.1.2.3. Các phương pháp optimize GD#

3.3.1.2.3.1. Newton#

Là phương pháp tìm nghiệm điểm tối ưu (thay vì GD) bằng hessian matrix và inverse matrix

Không có tính ứng dụng trong thực tiễn cho dữ liệu nhiều chiều hoặc do sự phúc tạp trong tính toán

3.3.1.2.3.2. Learning rate changes#

1. Decay lr

Learning rate giảm qua mỗi epoch, tuy nhiên ko control được yếu tố còn lại là gradient $\(lr_{new} = \frac{lr_{old}}{1 + \text{decay rate} * \text{num rate}}\)$

2. Scheduled drop lr

Lr drop sau 1 chu kỳ nhất định

3. Adaptive lr

Lr thay đổi dựa vào value của hàm Loss

4. Cycling lr

Lr thay đổi trong 1 cycle và lặp lại sự thay đổi đó trong cycle tiếp theo.

3.3.1.2.3.3. Momentum#

Điều chỉnh gradient bằng hướng di chuyển trước đó (bổ sung momentum vào update weight). Quy trình:

Set vận tốc ban đầu \(v_0\) = 0

Với mỗi 1 epoch thứ t:

gradient : \(\nabla w_{t-1}\)

Vận tốc mới: \(v_{t}=\gamma v_{t-1} + \eta \nabla w_{t-1}\)

Update weight: \(W_t = W_{t-1} - v_t\)

Lựa chọn \(\gamma\):

Nếu \(\gamma\) càng lớn thì update càng có hướng smooth do tỷ trọng hướng di chuyển trước đó càng cao, đồng nghĩa với tỷ trọng việc học mới càng thấp.

Nên lựa chọn \(\gamma\) in [0.8, 0.99]

\(\gamma\) cang cao thì càng làm giảm khả năng hội tụ và có thể vượt qua local minimum hiện tại.

Momentum giúp giảm giao động, nhanh đưa loss về điểm local minimum. Mặt khác, sử dụng vận tốc để update weight nên việc học sẽ không dừng lại ngay cả khi có gradient = 0. Từ đó có khả năng vượt qua local minimum để khám phá các điểm loss mới.

Sử dụng momentum có 1 nhược điểm là khi gần tới điểm hội tụ thì mất nhiều thời gian để dưng lại vì lúc nào cũng có đà di chuyển trước đó

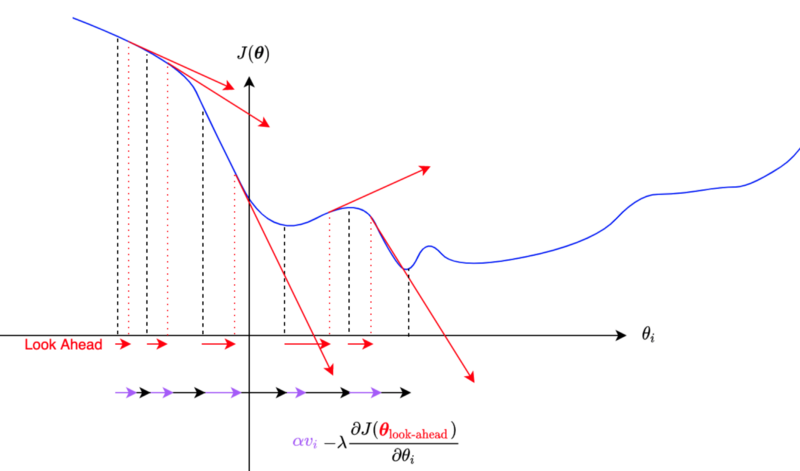

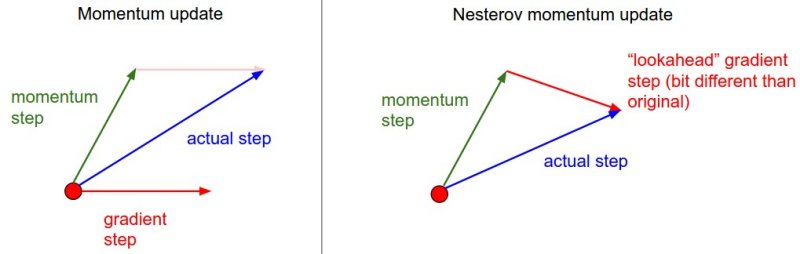

3.3.1.2.3.4. Nestorov accelerated gradient (NAG)#

NAG giải quyết vấn đề lâu hội tụ tại gần điểm optimize do vấn đề momentum gây ra, bằng việc sử dụng gradient của bước tiếp theo mà ko tính momentum (thay vì gradient của bước hiện tại như momentum)

Khi GD ko sử dụng momentum thì “gradient tại điểm xấp xỉ tiếp theo” chính là lượng thay đổi tại điểm mới nhưng ko có momentum

Vận tốc mới: \(v_{t}=\gamma v_{t-1} + \eta \nabla (w_{t-1} - \gamma v_{t-1})\)

Update weight: \(W_t = W_{t-1} - v_t\)

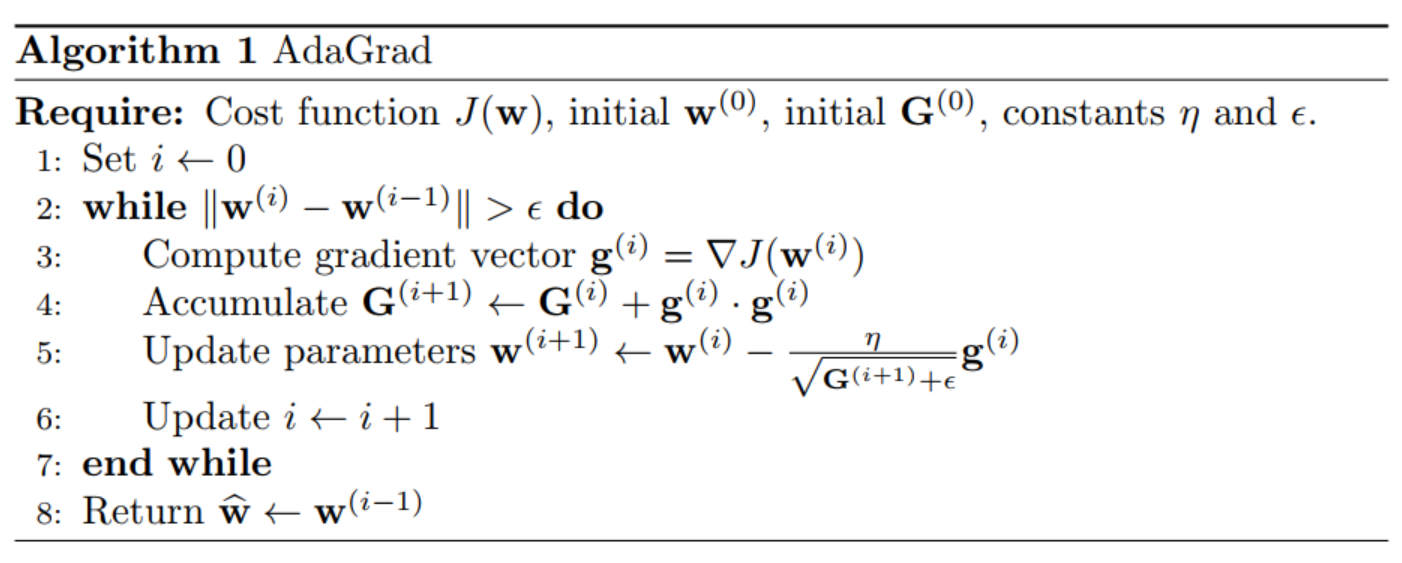

3.3.1.2.3.5. Adagrad#

Điều chỉnh lr bưởi tổng gradient^2 trước đó, do tổng gradient^2 càng ngày càng tăng nên Lr sẽ càng giảm theo thời gian, dẫn tới tác động của gradient hiện tại càng ít, có thể bị mất gradient

3.3.1.2.3.6. RMSprop#

RMSprop thay đổi hệ số của gradient, khắc phục được nhược điểm của AdaGrad là càng học càng chậm

Trung bình có trọng số của bình phương các gradient trong quá khứ \(G_t\) có trọng số \(\gamma\): \({\bf G}_{t} = \gamma{\bf G}_{t-1}+({1-\gamma}){\bf g}_{t}^{2}\)

update weight : \({\bf w}_{t} = {\bf w}_{t-1}-\frac{\eta}{\sqrt{{\bf G}_{t}+\epsilon}}g_t\)

Thuật toán RMSProp rất giống với Adagrad ở chỗ cả hai đều sử dụng bình phương của gradient để thay đổi tỉ lệ hệ số.

RMSProp có điểm chung với phương pháp động lượng là chúng đều sử dụng trung bình rò rỉ. Tuy nhiên, RMSProp sử dụng kỹ thuật này để điều chỉnh tiền điều kiện theo hệ số.

Trong thực tế, tốc độ học cần được định thời bởi người lập trình.

Hệ số 𝛾 xác định độ dài thông tin quá khứ được sử dụng khi điều chỉnh tỉ lệ theo từng tọa độ.

3.3.1.2.3.7. Ada-delta#

Adadelta tương tự như RMSprop, tức là điều chỉnh điều chỉnh mức độ cập nhật gradient vào trọng số thông qua \({\bf G}_{t}\) và \({\bf S}_{t}\), không cần thông qua learning_rate. Cụ thể quy trình tính:

Tính trung bình có trọng số của bình phương các gradient trong quá khứ: $\({\bf G}_{t} = \gamma{\bf G}_{t-1}+({1-\gamma}){\bf g}_{t}^{2}\)$

Update weight: $\({\bf w}_{t} = {\bf w}_{t-1}-\sqrt{\frac{{\bf S}_{t-1}+\epsilon}{{\bf G}_{t}+\epsilon}}g_t\)$

Tính trung bình có trọng số của các weight trong quá khứ: $\({\bf S}_{t} = \gamma{\bf S}_{t-1}+({1-\gamma}) w_t\)$

Tóm lại:

Adadelta không sử dụng tham số tốc độ học. Thay vào đó, nó sử dụng tốc độ thay đổi của chính bản thân các tham số để điều chỉnh tốc độ học.

Adadelta cần sử dụng hai biến trạng thái để lưu trữ các mô-men bậc hai của gradient và của lượng thay đổi trong các tham số.

Adadelta sử dụng trung bình rò rỉ để lưu ước lượng động của các giá trị thống kê cần thiết.

3.3.1.2.3.8. Adam#

Adam kết hợp sự thay đổi momentum dựa theo gradient bậc 1 và bậc 2 :

tính trung bình có trong số momentum và có hiệu chỉnh: $\( \hat{m}_t = \frac{\beta_1 m_{t-1} + (1- \beta_1) g_t}{1-\beta_1^t} \)$

tính trung bình có trong số momentum bậc 2 và có hiệu chỉnh: $\( \hat{v}_t = \frac{\beta_2 v_{t-1} + (1- \beta_2) g_t^2}{1-\beta_2^t} \)$

update weight t+1: $\(w_{t+1} = w_{t} - \frac{\eta}{\sqrt{\hat{v}_t } +\epsilon} \hat{m}_t\)$

default: \(\beta_1 = 0.9\) , \(beta_2 = 0.999\) , \(\epsilon = 10^{-8}\)

Tóm lại:

Adam kết hợp các kỹ thuật của nhiều thuật toán tối ưu thành một quy tắc cập nhật khá mạnh mẽ.

Dựa trên RMSProp, Adam cũng sử dụng trung bình động trọng số mũ cho gradient ngẫu nhiên theo minibatch.

Adam sử dụng phép hiệu chỉnh độ chệch (bias correction) để điều chỉnh cho trường hợp khởi động chậm khi ước lượng động lượng và mô-men bậc hai.

Đối với gradient có phương sai đáng kể, chúng ta có thể gặp phải những vấn đề liên quan tới hội tụ. Những vấn đề này có thể được khắc phục bằng cách sử dụng các minibatch có kích thước lớn hơn

3.3.1.2.3.9. NaAdam#

Tương tự như Adam nhưng NaAdam sử dụng NAG momentum thay cho vanilla momentum component (như của Adam). Nhắc lại là NAG giúp hội tụ tại khu vực minimal nhanh hơn so với vanilla momentum:

tính trung bình có trong số momentum và có hiệu chỉnh: $\( \hat{m}_t = \frac{\beta_1 m_{t-1} + (1- \beta_1) g_t}{1-\beta_1^t} \)$

tính trung bình có trong số momentum bậc 2 và có hiệu chỉnh: $\( \hat{v}_t = \frac{\beta_2 v_{t-1} + (1- \beta_2) g_t^2}{1-\beta_2^t} \)$

update weight t+1: $\(w_{t+1} = w_{t} - \frac{\eta}{\sqrt{\hat{v}_t } +\epsilon} (\beta_1 \hat{m}_t + (1- \beta_1) g_t)\)$

default: \(\beta_1 = 0.9\) , \(beta_2 = 0.999\) , \(\epsilon = 10^{-8}\)

3.3.1.2.4. Loss Function#

Loss thể hiện sự khác biệt / error giữa predictive (với regression là giá trị dự đoán, classification là xác suất) và real value

1. Classification

Log Loss/ Cross entropy Loss: có thể bị loss thay đổi lớn khi gặp các extremely value x, dữ liệu cần phải ở trạng thái balance

Focal loss: phù hợp trong TH dữ liệu imbalance

KL Divergence: xác định tính tương đồng của phân phối của predict và actual

Exponential loss: thường sử dụng khi muốn kết hợp nhiều model độc lập đã có hàm loss riêng, tạo thành 1 hàm loss tổng hợp

Hinge loss: tìm đường phân loại (hyperplane) để chia các nhóm ( tính distance từ hyperplane tới các nhóm)

2. Regression

Root mean squared error

Mean absolute error

Huber loss

Log cosh loss

Quantile loss

3.3.1.2.4.1. Cross Entropy Loss#

Trong đó:

x là 1 class trong tập class C

p(x) là xác suất thực của class x

q(x) là xác suất dự đoán của class x

Nếu p(x) == q(x) thì CE = 0, ngược lại nếu p(x) khác xa q(x) thì CE loss sẽ rất lớn

Một số biến thể:

Categorical Cross Entropy

Binary Cross Entropy

3.3.1.2.4.2. Focal loss#

Trong đó:

x là 1 class trong tập class C

\(p_x\) là xác suất dự đoán của class x

\(\alpha_x\) là the balancing parameter for the true class, nếu \(\alpha_x\) gần 1 thì more loss cho y = 1 tức focal_loss(FN) > focal_loss(FP)

\(\gamma\) thể hiện mức độ chênh lệch giữa từng class

\(\gamma = 0\): thì FL = Binary CE

\(\gamma\) >> 0: thì càng tăng loss cho class có balance thấp

So sánh với Cross Entropy, Focal tác động thêm trọng số với mục tiêu tăng tỷ trọng class có tỷ lệ thấp và giảm tỷ trọng class có tỷ lệ cao. Ứng dụng vào các bài toán object classification hoặc bài toán có class bị imbalance, khi đó với focal loss sẽ tập trung học những class khó dự đoán, ít update weight bởi các class dễ dự đoán

3.3.1.3. Get started with TF#

# check system

import sys

import tensorflow as tf

import platform

print(f"Python Platform: {platform.platform()}")

print(f"Python {sys.version}")

print(f"TensorFlow Version: {tf.__version__}")

print(f"Keras Version: {tf.keras.__version__}")

gpu = len(tf.config.list_physical_devices('GPU'))>0

print("GPU is", "available" if gpu else "NOT AVAILABLE")

Python Platform: macOS-13.1-arm64-arm-64bit

Python 3.10.9 (main, Jan 11 2023, 09:18:18) [Clang 14.0.6 ]

TensorFlow Version: 2.12.0

Keras Version: 2.12.0

GPU is available

3.3.1.4. Tensor#

Tensor tương tự như numpy array (array n chiều) nhưng cho phép sử dụng GPU/TPU để tính toán, từ đó tăng tốc độ tính toán và khả năng hội tụ của mạng.

Tensor đóng vai trò là input và output của mạng NN, trong các class tf.data hoặc tf.io sẽ tự động convert data sang tensor, mặc định dtype là int32 hoặc float32.

Một tensor có thể có số lượng dimensions không giới hạn.

Ví dụ, biến đổi một series of images thành tensors with shape (224, 224, 3, 32), trong đó:

224, 224 (the first 2 dimensions) là kích thước ảnh in pixels.

3 là số kênh màu của ảnh (red, green blue).

32 là the batch size (the number of images a neural network sees at any one time).

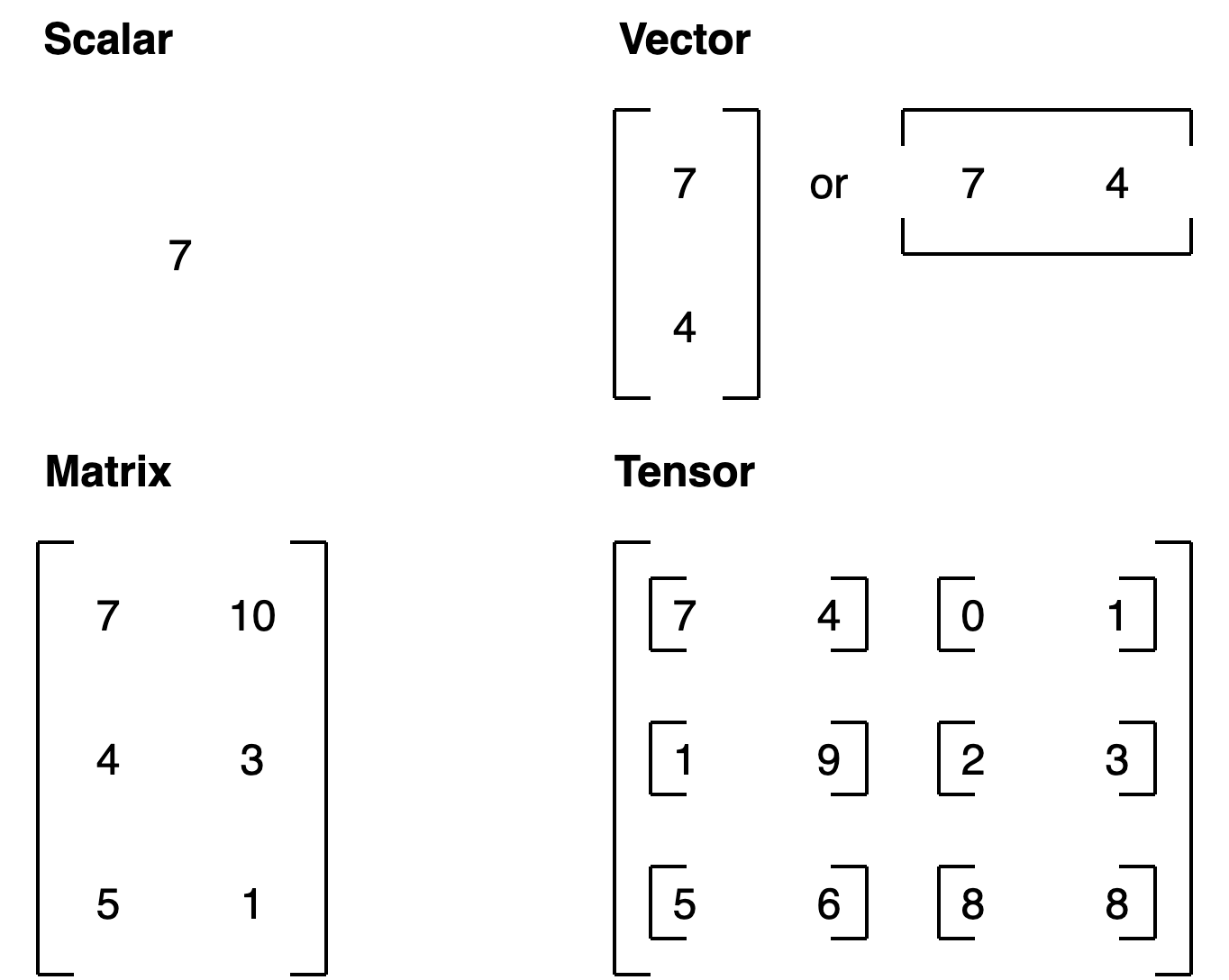

Có những loại tensors sau:

scalar: a single number.

vector: a number with direction (e.g. tốc đọ gió kèm hướng gió).

matrix: ma trận số 2 chiều.

tensor: một n-dimensional array of numbers (trong đó n có thể là bất kỳ số nào, a 0-dimension tensor is a scalar, a 1-dimension tensor is a vector).

For more on the mathematical difference between scalars, vectors and matrices see the visual algebra post by Math is Fun.

3.3.1.4.1. create tensor#

3.3.1.4.1.1. create tensor with tf.constant#

# scalar , rank = 0

scalar = tf.constant(10)

scalar

Metal device set to: Apple M1 Pro

<tf.Tensor: shape=(), dtype=int32, numpy=10>

# check number of dimensions

scalar.ndim

0

# Create a vector (1 dimensions)

vector = tf.constant([10, 10])

print(vector.ndim)

vector

1

<tf.Tensor: shape=(2,), dtype=int32, numpy=array([10, 10], dtype=int32)>

# Create matrix and define the datatype (default int32, float32)

matrix = tf.constant([[10., 7.],

[3., 2.],

[8., 9.]], dtype=tf.float16) # specify the datatype with 'dtype'

matrix

<tf.Tensor: shape=(3, 2), dtype=float16, numpy=

array([[10., 7.],

[ 3., 2.],

[ 8., 9.]], dtype=float16)>

# Create tensor (more than 2 dimensions, although, all of the above items are also technically tensors)

tensor = tf.constant([[[1, 2, 3],

[4, 5, 6]],

[[7, 8, 9],

[10, 11, 12]],

[[13, 14, 15],

[16, 17, 18]],

[[13, 14, 15],

[16, 17, 18]]])

tensor

<tf.Tensor: shape=(4, 2, 3), dtype=int32, numpy=

array([[[ 1, 2, 3],

[ 4, 5, 6]],

[[ 7, 8, 9],

[10, 11, 12]],

[[13, 14, 15],

[16, 17, 18]],

[[13, 14, 15],

[16, 17, 18]]], dtype=int32)>

3.3.1.4.1.2. create tensors with tf.Variable()#

tensor được tạo bởi

tf.constant()là dạng ko thể thay đổi được, thường dùng trong việc tạo mới tensortensor được tạo bởi

tf.Variable()có thể thay đổi được

Which one should you use?

tf.constant()ortf.Variable()?

It will depend on what your problem requires. However, most of the time, TensorFlow will automatically choose for you (when loading data or modelling data).

# Create the same tensor with tf.Variable() and tf.constant()

changeable_tensor = tf.Variable([10, 7])

unchangeable_tensor = tf.constant([10, 7])

changeable_tensor, unchangeable_tensor

(<tf.Variable 'Variable:0' shape=(2,) dtype=int32, numpy=array([10, 7], dtype=int32)>,

<tf.Tensor: shape=(2,), dtype=int32, numpy=array([10, 7], dtype=int32)>)

# change in tf.Variable()

changeable_tensor[0].assign(7)

changeable_tensor

<tf.Variable 'Variable:0' shape=(2,) dtype=int32, numpy=array([7, 7], dtype=int32)>

3.3.1.4.1.3. create random tensor#

Trong quá trình khởi tạo mạng NN, các weight sẽ được tạo ra random (random tensor) trước khi tiến tới các weight tối ưu trong quá trình học

random_1 = tf.random.Generator.from_seed(42) # set the seed for reproducibility

random_1 = random_1.normal(shape=(3, 2)) # create tensor from a normal distribution

random_1

<tf.Tensor: shape=(3, 2), dtype=float32, numpy=

array([[-0.75658023, -0.06854693],

[ 0.07595028, -1.2573844 ],

[-0.23193759, -1.8107857 ]], dtype=float32)>

3.3.1.4.1.4. zero/one tensor#

# Make a tensor of all ones

tf.ones(shape=(3, 2))

<tf.Tensor: shape=(3, 2), dtype=float32, numpy=

array([[1., 1.],

[1., 1.],

[1., 1.]], dtype=float32)>

# Make a tensor of all zeros

tf.zeros(shape=(3, 2))

<tf.Tensor: shape=(3, 2), dtype=float32, numpy=

array([[0., 0.],

[0., 0.],

[0., 0.]], dtype=float32)>

3.3.1.4.1.5. tensor from numpy array#

import numpy as np

numpy_A = np.arange(1, 25, dtype=np.int32) # create a NumPy array between 1 and 25

A = tf.constant(numpy_A,

shape=[2, 4, 3]) # note: the shape total (2*4*3) has to match the number of elements in the array

numpy_A, A

(array([ 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17,

18, 19, 20, 21, 22, 23, 24], dtype=int32),

<tf.Tensor: shape=(2, 4, 3), dtype=int32, numpy=

array([[[ 1, 2, 3],

[ 4, 5, 6],

[ 7, 8, 9],

[10, 11, 12]],

[[13, 14, 15],

[16, 17, 18],

[19, 20, 21],

[22, 23, 24]]], dtype=int32)>)

3.3.1.4.1.6. convert to numpy array#

np.array(A)

# or

A.numpy()

array([[[ 1, 2, 3],

[ 4, 5, 6],

[ 7, 8, 9],

[10, 11, 12]],

[[13, 14, 15],

[16, 17, 18],

[19, 20, 21],

[22, 23, 24]]], dtype=int32)

3.3.1.4.2. tensor function#

3.3.1.4.2.1. info: ndim, rank, size, shape#

Shape: The length (number of elements) of each of the dimensions of a tensor.

Rank: The number of tensor dimensions. A scalar has rank 0, a vector has rank 1, a matrix is rank 2, a tensor has rank n.

Axis or Dimension: A particular dimension of a tensor.

Size: The total number of items in the tensor.

tensor

<tf.Tensor: shape=(4, 2, 3), dtype=int32, numpy=

array([[[ 1, 2, 3],

[ 4, 5, 6]],

[[ 7, 8, 9],

[10, 11, 12]],

[[13, 14, 15],

[16, 17, 18]],

[[13, 14, 15],

[16, 17, 18]]], dtype=int32)>

tensor.dtype

tf.int32

# number of dimension

tensor.ndim

3

# shape

tensor.shape

TensorShape([4, 2, 3])

# size: tổng số element trong tensor

tf.size(tensor).numpy()

24

3.3.1.4.2.2. indexing#

# indexing tensor

tensor2 = tensor[:2,:1,:2]

tensor2

<tf.Tensor: shape=(2, 1, 2), dtype=int32, numpy=

array([[[1, 2]],

[[7, 8]]], dtype=int32)>

3.3.1.4.2.3. shuffle#

shuffle giúp hạn chế việc model chỉ học 1 số class nhất định được order theo thứ tự

tf.random.shuffle(tensor)

<tf.Tensor: shape=(4, 2, 3), dtype=int32, numpy=

array([[[ 1, 2, 3],

[ 4, 5, 6]],

[[13, 14, 15],

[16, 17, 18]],

[[ 7, 8, 9],

[10, 11, 12]],

[[13, 14, 15],

[16, 17, 18]]], dtype=int32)>

3.3.1.4.2.4. expand dim#

tensor3 = tensor2[0][0]

tensor3

<tf.Tensor: shape=(2,), dtype=int32, numpy=array([1, 2], dtype=int32)>

tf.expand_dims(tensor3, axis=-1) # "-1" means last axis

<tf.Tensor: shape=(2, 1), dtype=int32, numpy=

array([[1],

[2]], dtype=int32)>

tf.expand_dims(tensor3, axis=0) # "-1" means last axis

<tf.Tensor: shape=(1, 2), dtype=int32, numpy=array([[1, 2]], dtype=int32)>

# Insert another dimension

print('\n\n1\n',tensor3[:, tf.newaxis])

print('\n\n2\n',tensor3[:, tf.newaxis])

1

tf.Tensor(

[[1]

[2]], shape=(2, 1), dtype=int32)

2

tf.Tensor(

[[1]

[2]], shape=(2, 1), dtype=int32)

3.3.1.4.2.5. set global random seed#

sửu dụng global level random seed sẽ fix seed cố định cho mọi hàm có sử dụng tới yếu tố random và không được set operation level random seed

tf.random.set_seed(21) # global random seed

tf.random.shuffle(tensor2,seed = None) # operation level random seed

<tf.Tensor: shape=(2, 1, 2), dtype=int32, numpy=

array([[[1, 2]],

[[7, 8]]], dtype=int32)>

3.3.1.4.2.6. reshape#

# Create (3, 2) tensor

X = tf.constant([[1, 2],

[3, 4],

[5, 6]])

tf.reshape(X, shape=(2, 3))

<tf.Tensor: shape=(2, 3), dtype=int32, numpy=

array([[1, 2, 3],

[4, 5, 6]], dtype=int32)>

3.3.1.4.2.7. transpose#

tf.transpose(X)

<tf.Tensor: shape=(2, 3), dtype=int32, numpy=

array([[1, 3, 5],

[2, 4, 6]], dtype=int32)>

3.3.1.4.3. tensor operations#

3.3.1.4.3.1. Change datatype#

change datatype make model run faster and use less memory

tf.cast(tensor, dtype=tf.float16)

<tf.Tensor: shape=(2, 2), dtype=float16, numpy=

array([[1., 2.],

[3., 4.]], dtype=float16)>

3.3.1.4.3.2. Basic operation#

tensor = tf.constant([[1,2],[3,4]])

tensor

<tf.Tensor: shape=(2, 2), dtype=int32, numpy=

array([[1, 2],

[3, 4]], dtype=int32)>

# add value

tensor + 10

<tf.Tensor: shape=(2, 2), dtype=int32, numpy=

array([[11, 12],

[13, 14]], dtype=int32)>

# Subtraction

tensor - 10

<tf.Tensor: shape=(2, 2), dtype=int32, numpy=

array([[-9, -8],

[-7, -6]], dtype=int32)>

# Multiplication

tensor * 2

# or

tf.multiply(tensor, 2) # prefer using

<tf.Tensor: shape=(2, 2), dtype=int32, numpy=

array([[2, 4],

[6, 8]], dtype=int32)>

tensor * tensor

<tf.Tensor: shape=(2, 2), dtype=int32, numpy=

array([[ 1, 4],

[ 9, 16]], dtype=int32)>

3.3.1.4.3.3. Dot product / multiplication#

3.3.1.4.3.3.1. tf.matmul#

# Create (3, 2) tensor

X = tf.constant([[1, 2],

[3, 4],

[5, 6]])

# Create another (3, 2) tensor

Y = tf.constant([[7, 8],

[9, 10],

[11, 12]])

X, Y

(<tf.Tensor: shape=(3, 2), dtype=int32, numpy=

array([[1, 2],

[3, 4],

[5, 6]], dtype=int32)>,

<tf.Tensor: shape=(3, 2), dtype=int32, numpy=

array([[ 7, 8],

[ 9, 10],

[11, 12]], dtype=int32)>)

tf.matmul(X, tf.transpose(Y))

<tf.Tensor: shape=(3, 3), dtype=int32, numpy=

array([[ 23, 29, 35],

[ 53, 67, 81],

[ 83, 105, 127]], dtype=int32)>

# or

X @ tf.transpose(Y)

<tf.Tensor: shape=(3, 3), dtype=int32, numpy=

array([[ 23, 29, 35],

[ 53, 67, 81],

[ 83, 105, 127]], dtype=int32)>

# or

# You can achieve the same result with parameters

tf.matmul(a=X, b=Y, transpose_a=False, transpose_b=True)

<tf.Tensor: shape=(3, 3), dtype=int32, numpy=

array([[ 23, 29, 35],

[ 53, 67, 81],

[ 83, 105, 127]], dtype=int32)>

3.3.1.4.3.3.2. tf.tensordot#

Sử dụng khi muốn customize nhân matrix cho tensor (any dimention), do đó sẽ tốn kém chi phí hơn

Z = tf.random.uniform(shape=(3, 2, 2), minval=0, maxval=10 ,dtype = tf.int32)

Z

<tf.Tensor: shape=(3, 2, 2), dtype=int32, numpy=

array([[[9, 0],

[3, 6]],

[[4, 3],

[3, 8]],

[[0, 5],

[3, 4]]], dtype=int32)>

tf.transpose(X)

<tf.Tensor: shape=(2, 3), dtype=int32, numpy=

array([[1, 3, 5],

[2, 4, 6]], dtype=int32)>

tf.matmul(Z[0], tf.transpose(X))

<tf.Tensor: shape=(2, 3), dtype=int32, numpy=

array([[ 9, 27, 45],

[15, 33, 51]], dtype=int32)>

tf.tensordot(Z, tf.transpose(X), axes = 1)

<tf.Tensor: shape=(3, 2, 3), dtype=int32, numpy=

array([[[ 9, 27, 45],

[15, 33, 51]],

[[10, 24, 38],

[19, 41, 63]],

[[10, 20, 30],

[11, 25, 39]]], dtype=int32)>

3.3.1.4.3.4. absolute#

# Create tensor with negative values

D = tf.constant([-7, -10])

tf.abs(D)

<tf.Tensor: shape=(2,), dtype=int32, numpy=array([ 7, 10], dtype=int32)>

3.3.1.4.3.5. aggregation#

max/min

sum

mean

std

variance

argmax/argmin

Z

<tf.Tensor: shape=(3, 2, 2), dtype=int32, numpy=

array([[[9, 0],

[3, 6]],

[[4, 3],

[3, 8]],

[[0, 5],

[3, 4]]], dtype=int32)>

# max (whole tensor)

tf.math.reduce_max(Z)

<tf.Tensor: shape=(), dtype=int32, numpy=9>

tf.math.reduce_max(Z, axis = 2)

<tf.Tensor: shape=(3, 2), dtype=int32, numpy=

array([[9, 6],

[4, 8],

[5, 4]], dtype=int32)>

tf.math.reduce_max(Z, axis = 0)

<tf.Tensor: shape=(2, 2), dtype=int32, numpy=

array([[9, 5],

[3, 8]], dtype=int32)>

# find the position of maximum value

arg_max_ind = tf.math.argmax(Z)

arg_max_ind

<tf.Tensor: shape=(2, 2), dtype=int64, numpy=

array([[0, 2],

[0, 1]])>

A = tf.random.uniform(shape = [10], minval = 0, maxval = 10)

tf.reduce_min(A)

<tf.Tensor: shape=(), dtype=float32, numpy=1.4280438>

3.3.1.4.3.6. map function#

map specific function to each element unstacked on axis 0

tf.map_fn(tf.math.reduce_max, Z)

<tf.Tensor: shape=(3,), dtype=int32, numpy=array([9, 8, 5], dtype=int32)>

tf.map_fn(fn=lambda t: tf.range(t, t + 3), elems=tf.constant([3, 5, 2]))

<tf.Tensor: shape=(3, 3), dtype=int32, numpy=

array([[3, 4, 5],

[5, 6, 7],

[2, 3, 4]], dtype=int32)>

3.3.1.4.3.7. squeezing#

removing all single dimensions, xoá những dimension có rank 1, ví dụ shape:

(1, 1, 1, 1, 50) –> (50,)

(2, 1, 1, 25) –> (2,50)

# Create a rank 5 (5 dimensions) tensor of 50 numbers between 0 and 100

G = tf.constant(np.random.randint(0, 100, 50), shape=(1, 1, 1, 1, 50))

G

<tf.Tensor: shape=(1, 1, 1, 1, 50), dtype=int64, numpy=

array([[[[[93, 58, 58, 19, 47, 50, 31, 33, 2, 70, 58, 26, 72, 39, 54,

76, 48, 83, 91, 65, 75, 58, 71, 48, 37, 59, 84, 55, 2, 3,

62, 70, 63, 92, 16, 72, 67, 2, 6, 50, 47, 84, 55, 51, 8,

48, 34, 67, 57, 45]]]]])>

tf.squeeze(G)

<tf.Tensor: shape=(50,), dtype=int64, numpy=

array([93, 58, 58, 19, 47, 50, 31, 33, 2, 70, 58, 26, 72, 39, 54, 76, 48,

83, 91, 65, 75, 58, 71, 48, 37, 59, 84, 55, 2, 3, 62, 70, 63, 92,

16, 72, 67, 2, 6, 50, 47, 84, 55, 51, 8, 48, 34, 67, 57, 45])>

H = tf.constant(np.random.randint(0, 100, 50), shape=(2, 1, 1, 25))

H

<tf.Tensor: shape=(2, 1, 1, 25), dtype=int64, numpy=

array([[[[17, 8, 57, 43, 32, 83, 83, 61, 22, 93, 61, 28, 63, 34, 71,

35, 66, 27, 10, 38, 35, 95, 76, 37, 1]]],

[[[51, 22, 20, 77, 48, 24, 76, 54, 8, 11, 86, 99, 50, 16, 32,

99, 72, 60, 44, 40, 49, 16, 10, 59, 3]]]])>

tf.squeeze(H)

<tf.Tensor: shape=(2, 25), dtype=int64, numpy=

array([[17, 8, 57, 43, 32, 83, 83, 61, 22, 93, 61, 28, 63, 34, 71, 35,

66, 27, 10, 38, 35, 95, 76, 37, 1],

[51, 22, 20, 77, 48, 24, 76, 54, 8, 11, 86, 99, 50, 16, 32, 99,

72, 60, 44, 40, 49, 16, 10, 59, 3]])>

3.3.1.4.3.8. one-hot encoding#

# Create a list of indices

some_list = [0, 1, 2, 3]

# One hot encode them, need to specify the depth parameter

tf.one_hot(some_list, depth=4)

<tf.Tensor: shape=(4, 4), dtype=float32, numpy=

array([[1., 0., 0., 0.],

[0., 1., 0., 0.],

[0., 0., 1., 0.],

[0., 0., 0., 1.]], dtype=float32)>

tf.one_hot(some_list, depth=3)

<tf.Tensor: shape=(4, 3), dtype=float32, numpy=

array([[1., 0., 0.],

[0., 1., 0.],

[0., 0., 1.],

[0., 0., 0.]], dtype=float32)>

3.3.1.4.3.9. square / square_root / log#

tf.square()- get the square of every value in a tensor.tf.sqrt()- get the squareroot of every value in a tensor (note: the elements need to be floats or this will error).tf.math.log()- get the natural log of every value in a tensor (elements need to floats).

X

<tf.Tensor: shape=(3, 2), dtype=int32, numpy=

array([[1, 2],

[3, 4],

[5, 6]], dtype=int32)>

# square

tf.square(X)

<tf.Tensor: shape=(3, 2), dtype=int32, numpy=

array([[ 1, 4],

[ 9, 16],

[25, 36]], dtype=int32)>

# square root

tf.sqrt(tf.cast(X, dtype = tf.float32))

<tf.Tensor: shape=(3, 2), dtype=float32, numpy=

array([[1. , 1.4142135],

[1.7320508, 2. ],

[2.236068 , 2.4494898]], dtype=float32)>

# log

tf.math.log(tf.cast(X, dtype = tf.float32))

<tf.Tensor: shape=(3, 2), dtype=float32, numpy=

array([[0. , 0.6931472],

[1.0986122, 1.3862944],

[1.6094378, 1.7917594]], dtype=float32)>

3.3.1.4.4. @tf.function#

sử dụng decorator @tf.function để callable TensorFlow graph, giúp function chạy nhanh hơn

%%time

@tf.function

def function(x, y):

return x ** 2 + y

x = tf.constant(np.arange(0, 1000))

y = tf.constant(np.arange(1000, 2000))

z = function(x, y)

WARNING:tensorflow:AutoGraph could not transform <function function at 0x29833beb0> and will run it as-is.

Cause: Unable to locate the source code of <function function at 0x29833beb0>. Note that functions defined in certain environments, like the interactive Python shell, do not expose their source code. If that is the case, you should define them in a .py source file. If you are certain the code is graph-compatible, wrap the call using @tf.autograph.experimental.do_not_convert. Original error: could not get source code

To silence this warning, decorate the function with @tf.autograph.experimental.do_not_convert

WARNING: AutoGraph could not transform <function function at 0x29833beb0> and will run it as-is.

Cause: Unable to locate the source code of <function function at 0x29833beb0>. Note that functions defined in certain environments, like the interactive Python shell, do not expose their source code. If that is the case, you should define them in a .py source file. If you are certain the code is graph-compatible, wrap the call using @tf.autograph.experimental.do_not_convert. Original error: could not get source code

To silence this warning, decorate the function with @tf.autograph.experimental.do_not_convert

CPU times: user 18.3 ms, sys: 4.4 ms, total: 22.8 ms

Wall time: 25 ms

3.3.1.5. Configs and tools#

3.3.1.5.1. Training vs Inference Mode#

3.3.1.5.2. Use mixed_precision#

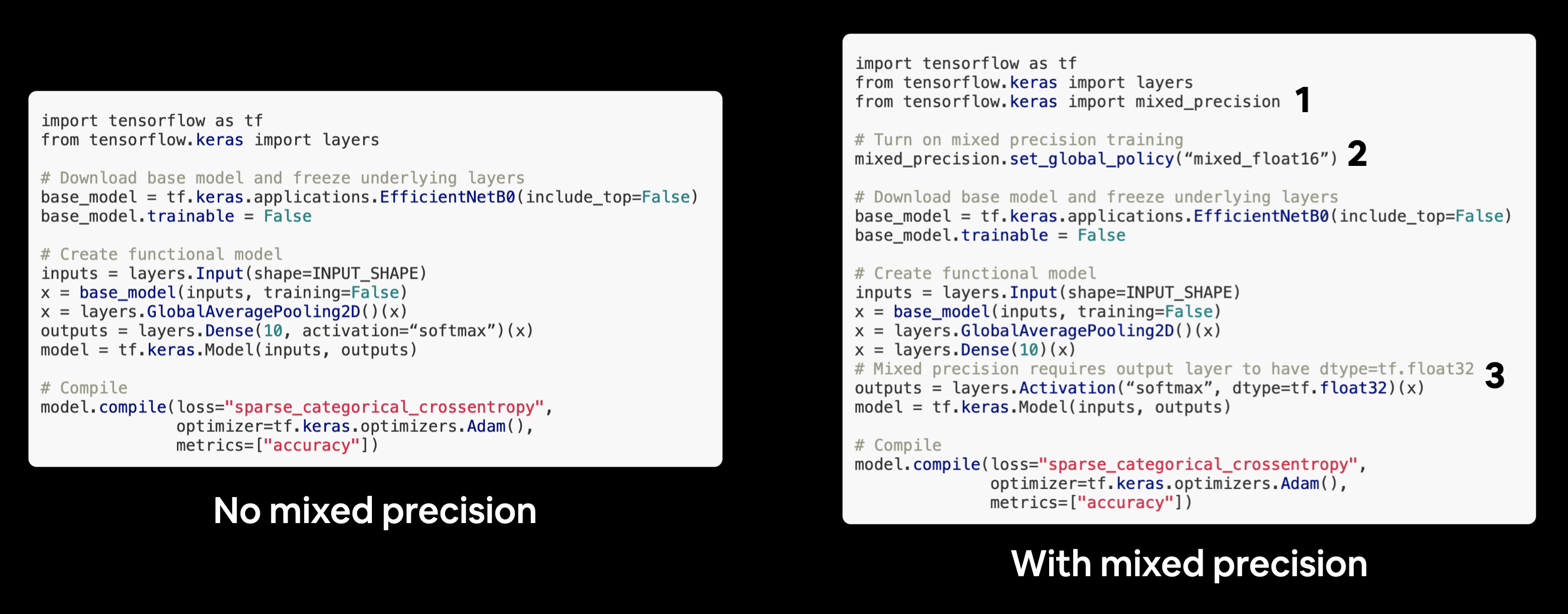

Thông thường, tensors in TF sử dụng mặc định datatype là float32 (single-precision floating-point format) , tương đương với việc sử dụng bộ nhớ 32 bits, tuy nhiên vì GPU có lượng memory nhất định, cho nên cần lựa chọn định dạng phù hợp để tối ưu chi phí lưu trữ là tính toán. Mixed precision training sử dụng kết hợp single precision (float32) and half-preicison (float16) data types để tăng tốc dộ training model (up 3x on modern GPUs). Khi đó, dữ liệu được chuyển từ 32 –> 16 nếu có thể.

Need to set output layer về dạng

float32bởi more stable for calculate loss function (detail for build model with mixed precision)

Does it make the model train faster?

Not much, but it saved us some seconds.

Does it effect the accuracy or performance of our model?

By 1% not that much tho.

What’s the advatanges of using mixed_precision training?

The advantages of mixed precision is evident when we are training pretty big models for longer epochs. In that case, we can spot a huge difference in our training time.

# Set global policy to mixed precision

from tensorflow.keras import mixed_precision

mixed_precision.set_global_policy(policy="mixed_float16")

from tensorflow.keras import layers

# Create base model

input_shape = (224, 224, 3)

base_model = tf.keras.applications.EfficientNetB0(include_top=False)

base_model.trainable = False # freeze base model layers

# Create Functional model

inputs = layers.Input(shape=input_shape, name="input_layer")

# Note: EfficientNetBX models have rescaling built-in but if your model didn't you could have a layer like below

# x = layers.Rescaling(1./255)(x)

x = base_model(inputs, training=False) # set base_model to inference mode only

x = layers.GlobalAveragePooling2D(name="pooling_layer")(x)

x = layers.Dense(len(class_names))(x) # want one output neuron per class

# Separate activation of output layer so we can output float32 activations

outputs = layers.Activation("softmax", dtype=tf.float32, name="softmax_float32")(x)

model = tf.keras.Model(inputs, outputs)

# Compile the model

model.compile(loss="sparse_categorical_crossentropy", # Use sparse_categorical_crossentropy when labels are *not* one-hot

optimizer=tf.keras.optimizers.Adam(),

metrics=["accuracy"])

Check the dtype_policy

layer.name: Tên của layerlayer.trainable: các tham số của layer có được train/update hay ko ?layer.dtype: the datatype của các biến trong layerlayer.dtype_policy: the datatype của các tính toán trong layer

Note: A layer can have a dtype of

float32and a dtype policy of “mixed_float16” because it stores its variables (weights & biases) infloat32(more numerically stable), however it computes infloat16(faster).

# Check the dtype_policy attributes of layers in our model

for layer in model.layers:

print(layer.name, layer.trainable, layer.dtype, layer.dtype_policy) # Check the dtype policy of layers

3.3.1.5.3. TF Profiler#

Analyze tf.data performance with the TF Profiler

3.3.1.6. Types of layers#

3.3.1.6.1. Basic#

3.3.1.6.1.1. Dense#

3.3.1.6.1.2. Activation#

AF giúp biến đổi non-linear các hàm ban đầu để phù hợp với thực tế, do hàm trước AF chỉ là tổ hợp tuyến tính

AF giúp hạn chế tác động và kiểm soát những value lớn

Trong việc learn của model, cần tránh các TH:

Học bùng nổ: hàm loss rất lớn khi có nhiễu

triệt tiêu thông tin: gradient trở nên rất bé và gần như ko học được gì

Lựa chọn activate function

Thông thường SELU > ELU > leaky ReLU (và các biến thể) > ReLU > tanh > logistic.

Quan tâm tới runtime, prefer leaky ReLU.

PReLU if you have a huge training set

Bài toán hình ảnh: ưu tiên hàm ReLU

NLP: sigmoid, Tanh, Ramp

For regression problems(Only 1 neuron, multiple inputs, real-world outputs), a linear activation function must be used.

For multi-class classification problems, use Softmax at the output layer

For multi-label and binary classification problems, use the Sigmoid activation function.

Sigmoid and hyperbolic tangent activation functions must be never used in the hidden layers as they can lead to vanishing gradients.

For networks where unnecessary neurons need to turn OFF, use ReLU as the activation function because it also works as a dropout layer. In case there is confusion about which activation function, use ReLU.It is used in most CNN problems.

For deep neural networks having greater than 40 layers, use the swish activation function.

import numpy as np

import plotly.graph_objects as go

from tensorflow.keras import activations as af

def derivative_value(func , x, step=1e-10):

return (func(x+step) - func(x)) / step

def plot_output_and_deriv(func, name = "", range_x = np.linspace(-5,5, 50)):

fig = go.Figure()

fig.add_trace(go.Scatter(x=x, y=[func(x) for x in range_x], mode='lines', name=name))

if func is not None:

y_deri = [derivative_value(func ,i) for i in x]

fig.add_trace(go.Scatter(x=x, y=y_deri, mode='lines+markers', name='derivative of '+name))

return fig.show(renderer = 'jpeg')

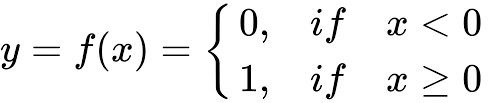

3.3.1.6.1.2.1. Unit step#

Mô tả: Input là toàn bộ số thực, trả về 1 nếu dương, trả 0 nếu âm

Đạo hàm: = 0

Pros: Đơn giản + dễ áp dụng

Cons: Đạo hàm = 0 nên không có tác dụng trong việc cập nhật trọng số

Usage: Thường áp dụng cho output layer thay vì hidden layer và áp dụng trong các bài toán binary classification

unitstep = lambda z: int(z>0 or z ==0)

plot_output_and_deriv(unitstep, 'unitstep')

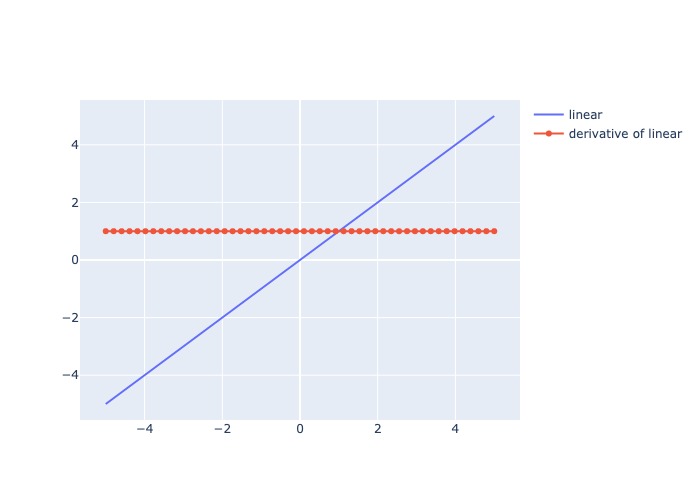

3.3.1.6.1.2.2. Linear#

Mô tả: Trả output là 1 hàm linear của input

Đạo hàm: = constant

Pros:

Range output rộng và không bị ràng buộc

Chi phí tính toán thấp

Không có hiện tượng biến mất gradient trong quá trình lan truyền ngược

Cons: Do đạo hàm cố định, tức giá trị update weight luôn cố định nên không phản ánh sự tương quan giữa X và y

Usage: Áp dụng cho các bài toán regression(univariate)

plot_output_and_deriv(af.linear, 'linear')

3.3.1.6.1.2.3. Softmax#

where \(z_i\) is the \(i\)-th element of the input vector, and \(k\) is the length of the vector

Mô tả: Chuẩn hoá các giá trị đầu vào về range (0,1) và có tổng bằng 1

Đạo hàm:

Pros:

Phù hợp multi-class classification do có sum = 1

Hàm liên tục và khả vi tại mọi vị trí, nên phù hơp với backpropagation

Cons:

Tốn chi phí tính toán

Chỉ dùng cho output layer

Usage:

Áp dụng cho output là multi-class classification

Chỉ áp dụng cho output layer

def softmax(x):

ex = np.exp(x)

sum_ex = np.sum( np.exp(x))

return ex/sum_ex

af.softmax

<function keras.activations.softmax(x, axis=-1)>

3.3.1.6.1.2.4. Sigmoid#

Mô tả: Nhận input số thực và trả ra value trong (0,1), số input càng lớn, output càng gần 1, input càng bé thì output càng gần 0

Đạo hàm: Thay đổi và luôn dương, lớn nhất tại x = 0 và bé nhất khi x càng lớn hoặc càng bé

Pros:

Weight luôn được cập nhật qua mỗi lần học

Hàm liên tục và khả vi tại mọi vị trí, nên phù hơp với backpropagation

Cons:

Tốn chi phí tính toán

Không có tính đối xứng qua số 0 nên học các negative value sẽ ít hơn so với positive value

vanishing gradient problem xuất hiện tại các điểm giá trị input quá lớn hoặc quá bé, khi đó derivative xấp xỉ 0

Usage:

Áp dụng cho output là xác suất hoặc bài toán binary classification

Nếu sử dụng cho multi-class classification thì tổng các xác suất sẽ khác 1, cần phải hiệu chỉnh lại bằng softmax

def sigmoid(z):

return 1 / (1 + np.exp(-z))

plot_output_and_deriv(af.sigmoid, 'sigmoid')

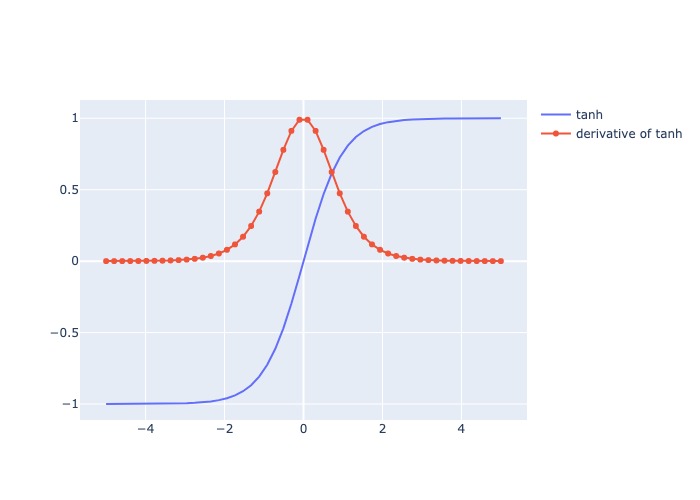

3.3.1.6.1.2.5. Hyperbolic Tangent (tanh)#

Mô tả:

Nhận input số thực và trả ra value trong (-1,1), số input càng lớn, output càng gần 1, input càng bé thì output càng gần -1

Giống sigmod nhưng range output = (-1,1)

Thường làm output tiến gần về/đến 0, tăng khả năng hội tụ

Đạo hàm: Thay đổi và luôn dương, lớn nhất tại x = 0 và bé nhất khi x càng lớn hoặc càng bé

Pros:

Weight luôn được cập nhật qua mỗi lần học

Hàm liên tục và khả vi tại mọi vị trí, nên phù hơp với backpropagation

Có tính đối xứng qua số 0 nên học các negative value ngang bằng positive value, do đó hội tụ nhanh hơn sigmoid

Cons:

Tốn chi phí tính toán

vanishing gradient problem xuất hiện tại các điểm giá trị input quá lớn hoặc quá bé, khi đó derivative xấp xỉ 0

Usage:

Thường áp dụng cho bài toán có nhiều output hoặc binary classification (sigmod thường áp dụng cho bài toán phân loại 2 output)

def tanh(z):

ez = np.exp(z)

enz = np.exp(-z)

return (ez - enz)/ (ez + enz)

plot_output_and_deriv(af.tanh, 'tanh')

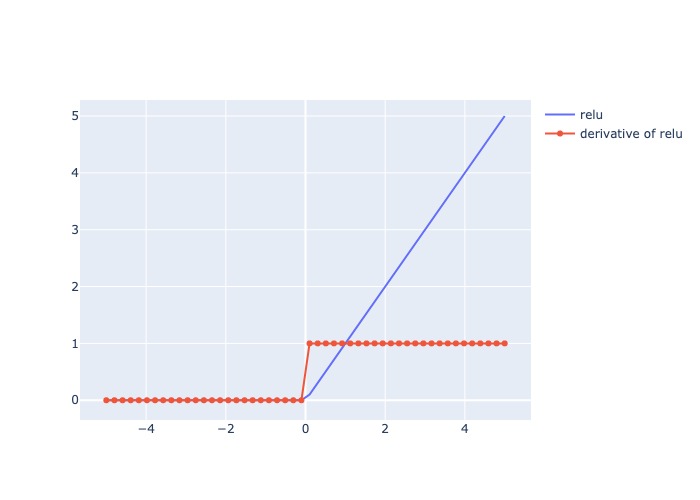

3.3.1.6.1.2.6. ReLU#

Mô tả:

Trả ra input nếu dương, trả ra 0 nếu âm (tạo thành dead node)

Đạo hàm: = 1 cho các giá trị input dương, và = 0 cho các giá trị input âm

Pros:

Tính toán nhanh

Có tính chất non-linear

Đạo hàm không đổi tại các value của x nên khắc phục các giá trị input bất tường hoặc lớn

best activation function cho CNNs bởi vì hiệu quả cho việc extracting features hoặc for pattern recognition.

Có thể hoạt động như 1 dropout layer ví dụ như deactive node nếu input = 0

Cons:

Với x giá trị âm, gradient = 0, có khả năng kết thúc sớm khi học.

Không khả vi tại 0 nên các continuous output không phù hợp áp dụng

Usage:

Thường áp dụng cho bài toán CNN, Natural Language Processing, Pattern Recognition

Trong bài toán nhận diện hình ảnh:

Chạy qua các điểm highlight sẽ có update > 0

Chạy qua vùng background sẽ không có update

relu = lambda i: max(0,i)

plot_output_and_deriv(af.relu, 'relu')

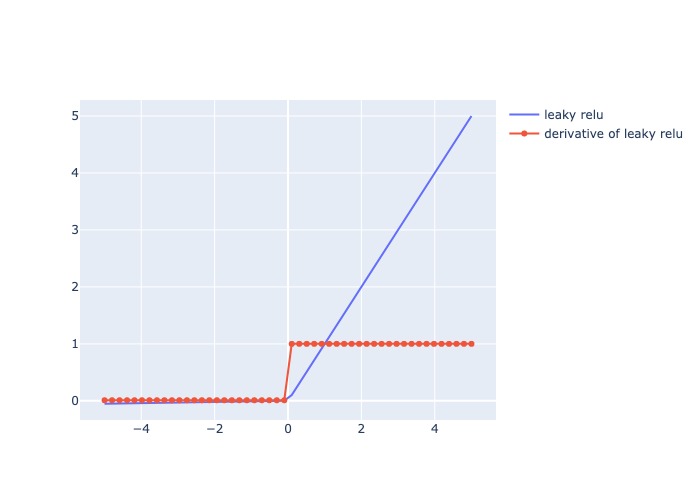

3.3.1.6.1.2.7. Leaky ReLU#

where \(\alpha\) is a small constant typically set to 0.01.

Mô tả:

Trả ra x nếu x dương, trả ra số 0.01x nếu x âm (vẫn tạo ra derivative khi x âm)

Đạo hàm: = 1 cho các giá trị input dương, và = 0.01 cho các giá trị input âm

Pros:

Có ưu điểm của RelU

Khắc phục sự chết của ReLU khi x âm, thay vào đó derivative = 0.01, tăng độ chính xác so với ReLU

Cons:

Với x giá trị âm bất kỳ đều có derivative = 0.01, nên quá trình học diễn ra lâu với bất kể x âm như nào

Usage:

Thường áp dụng cho bài toán CNN, Natural Language Processing, Pattern Recognition

lrelu = lambda i: i if (i >=0) else 0.01*i

lrelu = lambda x: af.relu(x, alpha = 0.01)

plot_output_and_deriv(lrelu, 'leaky relu')

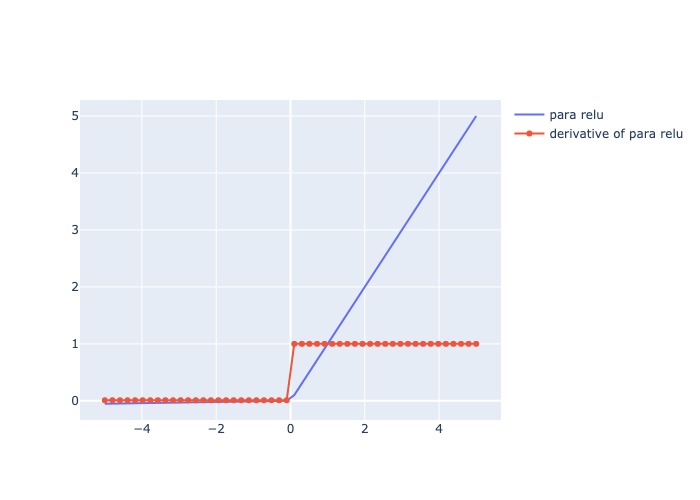

3.3.1.6.1.2.8. Parametric ReLU#

Mô tả:

Giống Leaky ReLU nhưng \(\alpha\) có thể set 1 giá trị bất kỳ

Đạo hàm: = 1 cho các giá trị input dương, và = \(\alpha\) cho các giá trị input âm

Pros:

Tăng độ chính xác và mức độ hội tụ nhanh hơn so với ReLU và Leaky ReLU

Cons:

Với x giá trị âm bất kỳ đều có derivative = \(\alpha\), nên quá trình học diễn ra lâu với bất kể x âm như nào

Cần check mức độ alpha phù hợp

Usage:

Thường áp dụng cho bài toán CNN, Natural Language Processing, Pattern Recognition

prelu = lambda x: af.relu(x, alpha = 0.5)

plot_output_and_deriv(lrelu, 'para relu')

3.3.1.6.1.2.9. Exponential Linear Unit (ELU)#

where \(\alpha\) is a hyperparameter that controls the slope of the function for negative inputs.

Mô tả:

Với giá trị input dương x, trả ra hàm linear, còn nếu x âm thì trả ra giá trị gần với mức \(-\alpha\), output range (-α,∞)

Đạo hàm: = 1 cho các giá trị input dương, và cho các giá trị input âm

Pros:

Tăng độ chính xác và mức độ hội tụ nhanh hơn so với ReLU và biến thể

Cons:

Cần tunning giá trị alpha

Chi phí tính toán lớn

Usage:

Thường áp dụng cho bài toán CNN, Natural Language Processing, Pattern Recognition

def ELU(z,α) :

return z if (z>0) else (α * (np.exp(z) - 1))

plot_output_and_deriv(af.elu, 'elu')

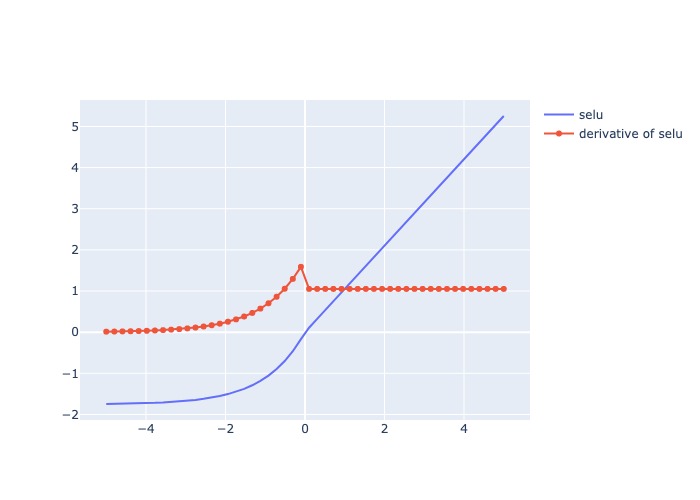

3.3.1.6.1.2.10. Scaled Exponential Linear Unit (SELU)#

Mô tả:

Đạo hàm: = 1 cho các giá trị input dương, và cho các giá trị input âm

Pros:

Không có hiện tượng biến mất gradient trong quá trình lan truyền ngược

Mạng nơ ron hội tụ nhanh hơn.

Đây là một hàm kích hoạt tự chuẩn hóa, nghĩa là giá trị trung bình trở thành 0 và phương sai thành 1.

Nó có thể được sử dụng trong các mạng thần kinh rất phức tạp.

Cons:

Chi phí tính toán lớn

Usage:

multi-class classification

plot_output_and_deriv(af.selu, 'selu')

3.3.1.6.1.2.11. Swish#

Mô tả:

Hàm trả output range (1/e,∞)

Với input dương, the output là 1 hàm linear của input. Với input âm, cho phép cập nhật 1 phần giá trị tại gần 0, với x quá âm thì ko cập nhật

Tuỳ thuộc vào \(\beta\):

\(\beta\) = 0: trở thành hàm linear

\(\beta\) = 1: trở thành hàm linear sigmoid

\(\beta\) = ∞: trở thành hàm ReLU

Đạo hàm: = 1 cho các giá trị input dương, và cho các giá trị input âm

Pros:

Tăng độ chính xác hơn ReLU

Có tính chất non-monotonic cho negative input

Là hàm liên tục và khả vi mọi điểm

Cons:

Chi phí tính toán lớn

Usage:

the same applications as ReLU

plot_output_and_deriv(af.swish, 'swish')

3.3.1.6.1.3. Input#

3.3.1.6.1.4. Flatten#

3.3.1.6.2. Pooling#

3.3.1.6.2.1. Max/Average Pooling#

Max-Pooling (

tf.keras.layers.MaxPool2D)

Max-Pooling thường được sử dụng trong CNN model, add phía sau các convolutional layer có tác dụng giảm chiều ảnh bằng cách giảm số pixels mỗi chiều của ảnh output từ convolutional layer trước, mà giữ lại được lượng lớn các features có ý nghĩa bằng việc lựa chọn ra giá trị lớn nhất trong cụm

Average-Pooling (

tf.keras.layers.AveragePooling2D)

Average-Pooling thường ít được sử dụng hơn so với Max-Pooling, trừ TH muốn thu gọn lại (thay vì muốn filter ra feature có ý nghĩa)

tf.keras.layers.MaxPool2D(

pool_size=(2, 2), # kích thước pool

strides=None, # bước nhảy

padding='valid', # có dùng padding outter = 0 hay ko ?

)

3.3.1.6.2.2. Global Max/Average Pooling#

Thường sử dụng để map the last convolutional layer vào trong mạng fully connected layers (tradicontional neural network). Global Average pooling layers giống như 1 Flatten layers in CNN, nhưng thay vì flatten full node (dễ overfitting nên cần dropout hoặc regularization) thì chúng lấy giá trị average/max của mỗi feature, và kết quả được fit trực tiếp vào softmax layer.

Một ưu điểm của Global Max/Average Pooling so với Flatten fully connected là chúng more native hơn so với mạng CNN bởi tạo ra tính kết nối giữa feature và category, hơn nữa chúng ko có parameter cần optimize, nên tránh được overfitting

tf.keras.layers.GlobalAveragePooling2D()

3.3.1.6.3. Convolution#

3.3.1.6.4. Regularization#

3.3.1.6.4.1. Weight regularization#

L1 regularization (LASSO)

Hàm Cost/Loss sẽ được bổ sung penalty L1 tương ứng theo khoảng cách manhattan

Khi đó hàm Loss sẽ luôn tiến sát về 0 nhưng cách 1 khoảng tối thiểu là mức penalty

Chỉ có giới hạn số điểm để Loss chạm được L1 min (điểm mà error = 0)

Giảm hệ số về 0 nên tốt cho feature selection, hiệu quả với dữ liệu sparsity, khi có nhiều inputs features và bạn tin rằng chỉ có 1 ít trong số chúng có ý nghĩa

L2 regularization (RIDGE)

Hàm Cost/Loss sẽ được bổ sung penalty L2 tương ứng theo khoảng cách euclidean

Khi đó hàm Loss sẽ luôn tiến sát về 0 nhưng cách 1 khoảng tối thiểu là mức penalty euclidean,

Có nhiều nghiệm thoả mãn min L2 hơn so với L1

Làm cho hệ số nhỏ hơn, có ý nghĩa trong việc tăng robost model bằng việc giải quyết multicollinearity problem

Nếu máy học W lớn thì Loss giảm nhưng Regularization tăng

Một hàm Cost tốt khi cả loss và Regu đều giảm

Sử dụng

L2phạt nặng hơnL1khiWtăng mạnhKết hợp

L1 + L2mang lại kết quả tốt hơn

from tensorflow.keras import regularizers

l1 = regularizers.l1(0.01)

l2 = regularizers.l2(0.01)

l1l2 = regularizers.l1_l2(l1=0.01, l2=0.01)

# weight regularization dense

Dense(32, kernel_regularizer=l2(0.01), bias_regularizer=l2(0.01))

# weight regularization convolutional layer

Conv2D(32, (3,3), kernel_regularizer=l2(0.01), bias_regularizer=l2(0.01))

3.3.1.6.4.2. Early stopping#

1. Giới hạn vòng lặp : MLPClassifier(max_iter=300)

nhược điểm là model có thể dừng trước khi hội tụ

2. So sánh gradient

So sánh gradient của nghiệm 2 lần update liên tiếp nếu chênh lệch với giá trị threshold

ảnh hưởng performance nếu việc tính toán đạo hàm quá phức tạp khi có dữ liệu lớn, ko được hưởng lợi từ SGD hoặc mini-batch GD

3. So sánh Loss: MLPClassifier(tol=0.0001)

So sánh los của 1 vài lần update, nếu hàm loss it thay đổi thì dừng

3. Đặt ngưỡng dừng cho Loss:

Thiết lập ngưỡng chấp nhận được cho Loss, nếu loss trong tập validate dưới mức đó trong quá trình training thì dừng lại

from tensorflow.keras.callbacks import EarlyStopping

earstop = EarlyStopping(

monitor='val_loss', # chỉ số tracking

min_delta=30, # giá trị tối thiểu cho phép thay đổi ngược

# ( ví dụ với accuracy là mức giảm tối thiểu cho phép,

# hoặc với MAE thì là mức tăng tối thiểu cho phép)

patience=4, # số epoch tối đa cho phép no improvement

verbose=0,

mode='auto',

baseline=None,

restore_best_weights=True, # restore model về best weights

start_from_epoch=100 # number epochs chạy trước khi bắt đầu monitoring

)

3.3.1.6.4.3. Dropout#

Việc quá nhiều nút (full connected) dẫn tới các nút phụ thuộc nhiều vào nhau. Vậy nên cần tắt bớt 1 số nút trong mạng thông qua việc set mỗi node có xác suất activate là p và deactivate là 1-p. Điều này giúp model tránh phụ thuộc quá nhiều bởi 1 số node cụ thể nào đó

Tuy nhiên có thể làm mất thông tin trong quá trình học do tắt 1 số nút quan trọng

tf.keras.layers.Dropout(

rate, noise_shape=None, seed=None, **kwargs

)

3.3.1.6.5. Batch Normalization#

BN thường sử dụng phía sau các layer fully connected dense/convolutional layer và phía trước non-linearity layer. Có tác dụng tăng learning rate và giảm tác động của những tham số khởi tạo ban đầu

BN đề cập đến việc chuẩn hóa giá trị input của layer bất kỳ. Chuẩn hóa có nghĩa là đưa phân phối của layer về xấp xỉ phân phối chuẩn với trung bình xấp xỉ 0 và phương sai xấp xỉ 1. Về mặc toán học, Batch Normalization (BN) thực hiện như sau: với mỗi layer, BN tính giá trị trung bình và phương sai của nó. Sau đó sẽ lấy giá trị đặc trưng trừ giá trị trung bình , sau đó chia cho độ lệch chuẩn. Data được chia nhỏ thành nhiều batch và normalize từng batch giúp:

Giảm tác động khi thay đổi nhỏ của weight

Dễ dàng optimize

Các weight có cùng cơ sở để so sánh với nhau

Giảm sự biến thiên giữa các batch

Normalize input

Normalize batch \({x_i}\) với \(\mu_B\), \(\sigma_B^2\) là mean và variance của batch. Các hyperparameter là \(\gamma\), \(\beta\)

Tác dụng của normalized

Giảm tác động của những tham số khởi tạo ban đầu

Speedup training time (tăng learning rate)

Hạn chế vanishing gradient (bị mất gradient theo lan truyền ngược)

Giảm overfitting do giảm tác động của noise và cố định phân phối của các feature qua các lớp layer. Sử dụng batch normalization, chúng ta sẽ không cần phải sử dụng quá nhiều dropput và điều này rất có ý nghĩa vì chúng ta sẽ không cần phải lo lắng vì bị mất quá nhiều thông tin khi dropout weigths của mạng

Hạn chế của BN

BN thực hiện lại các phép tính trình bày phía trên qua các lần lặp, cho nên, về lý thuyết, chúng ta cần batch size đủ lớn để phân phối của mini-batch xấp xỉ phân phối của dữ liệu. Điều này gây khó khăn cho các mô hình đòi hỏi ảnh đầu vào có chất lượng cao (1920x1080) như object detection, semantic segmentation, … Việc huấn luyện với batch size lớn làm mô hình phải tính toán nhiều và chậm

Với Batch size = 1, giá trị phương sai sẽ là 0. Do đó BN sẽ không hoạt động hiệu quả

BN không hoạt động tốt với RNN. Lý do là RNN có các kết nối lặp lại với các timestamps trước đó, và yêu cầu các giá trị beta và gamma khác nhau cho mỗi timestep, dẫn đến độ phức tạp tăng lên gấp nhiều lần, và gây khó khăn cho việc sử dụng BN trong RNN.

Trong quá trình test, BN không tính toán lại giá trị trung bình và phương sai của tập test. Mà sử dụng giá trị trung bình và phương sai được tính toán từ tập train. Điều này làm cho việc tính toán tăng thêm. Ỏ pytorch, hàm model.eval() giúp chúng ta thiết lập mô hình ở chế độ evaluation. Ở chế độ này, BN layer sẽ sử dụng các giá trị trung bình và phương sai được tính toán từ trước trong dữ liệu huấn luyện. Giúp cho chúng ta không phải tính đi tính lại giá trị này.

tf.keras.layers.BatchNormalization(

axis=-1,

momentum=0.99,

epsilon=0.001,

center=True,

scale=True,

beta_initializer='zeros',

gamma_initializer='ones',

moving_mean_initializer='zeros',

moving_variance_initializer='ones',

beta_regularizer=None,

gamma_regularizer=None,

beta_constraint=None,

gamma_constraint=None,

synchronized=False,

)

3.3.1.7. Data Augmentation#

3.3.1.7.1. Image Augmentation#

Models thường cần rất nhiều data ở các tính chất khác nhau để học, do đó cần phải sử dụng kỹ thuật data augmentation để transform image

Sử dụng tf.keras.layers để tạo data augmentation layer, mang lại hiệu quả hơn :

Preprocessing images sẽ được sử lý thông qua GPU thay vì CPU, cho nên tốc độ sẽ nhanh hơn

Note: Các dữ liệu dạng unstructured (images) sẽ phù hợp hơn khi xử lý trên GPU, con các dữ liệu có structured như

Augmentation data được xây dựng như 1 layer của model cho nên có thể export toàn bộ model (bao gồm cả lớp layer augmentation), và áp dụng các tham số augmentation được giữ nguyên

Data augmentation layers chỉ run khi training, do đó, khi thực hiện việc prediction hoặc evaluation model thì layer này được tự động turn-off (Chỉ có

ResizingvàRescalinglà run in inference mode, còn lại các transformation khác là run in training mode)

Một số data augmentation transformations được sử dụng phổ biến:

RandomFlip- flips image on horizontal or vertical axis. (lật ảnh ngang/dọc) (training)RandomRotation- randomly rotates image by a specified amount. (xoay ảnh) (training)RandomZoom- randomly zooms into an image by specified amount. (zoom ảnh) (training)RandomHeight- randomly shifts image height by a specified amount. (shift chiều cao) (training)RandomWidth- randomly shifts image width by a specified amount. (shift chiều rộng) (training)Rescaling- normalizes the image pixel values to be between 0 and 1 (normalization) (inference)Resizing- resize the image with specificly height and width. (resize image) (inference)

Rescalingis required for some image models, but EfficientNetB0 (keras apps) is not required.

# sử dụng data augmentation layer

data_aug = tf.keras.Sequential([

layers.RandomFlip("horizontal"),

layers.RandomRotation(0.2),

layers.RandomZoom(0.2),

layers.RandomHeight(0.2),

layers.RandomWidth(0.2),

# layers.Resizing(224,224), # (dont need to EfficientNetB0 because it's has)

# layers.Rescaling(1./255) # (dont need to EfficientNetB0 because it's has)

], name = 'data_augmentation')

3.3.1.7.2. Text Augmentation#

3.3.1.7.2.1. Back translation#

Translate text sang language khác, rồi sau có translate ngược lại ngôn ngữ ban đầu, giúp cho text mới sinh ra vấn giữ được nguyên ý nghĩa nhưng sử dụng các từ khác so với ban đầu

!pip install translators

import pandas as pd

# current version have logs, which is not very comfortable

import translators as ts

from multiprocessing import Pool

from tqdm import *

CSV_PATH = '../input/jigsaw-multilingual-toxic-comment-classification/jigsaw-toxic-comment-train.csv'

LANG = 'es'

API = 'google'

def translator_constructor(api):

if api == 'google':

return ts.google

elif api == 'bing':

return ts.bing

elif api == 'baidu':

return ts.baidu

elif api == 'sogou':

return ts.sogou

elif api == 'youdao':

return ts.youdao

elif api == 'tencent':

return ts.tencent

elif api == 'alibaba':

return ts.alibaba

else:

raise NotImplementedError(f'{api} translator is not realised!')

def translate(x):

try:

return [x[0], translator_constructor(API)(x[1], 'en', LANG), x[2]]

except:

return [x[0], None, [2]]

def imap_unordered_bar(func, args, n_processes: int = 48):

p = Pool(n_processes, maxtasksperchild=100)

res_list = []

with tqdm(total=len(args)) as pbar:

for i, res in tqdm(enumerate(p.imap_unordered(func, args))):

pbar.update()

res_list.append(res)

pbar.close()

p.close()

p.join()

return res_list

def main():

df = pd.read_csv(CSV_PATH).sample(100)

tqdm.pandas('Translation progress')

df[['id', 'comment_text', 'toxic']] = imap_unordered_bar(translate, df[['id', 'comment_text', 'toxic']].values)

df.to_csv(f'jigsaw-toxic-comment-train-{API}-{LANG}.csv')

if __name__ == '__main__':

main()

3.3.1.7.2.2. Easy Data Augmentation#

Synonym Replacement: thay thế 1 từ non-stopwords trong câu thành 1 từ khác tương ứng (có thể lặp lại n lần)

Random Insertion: tìm 1 từ đồng nghĩa với 1 từ ngẫu nhiên trong câu và chèn vào câu với vị trí ngẫu nhiên (có thể lặp lại n lần)

Random Swap: Chọn ngẫu nhiên 2 từ trong câu và swap position (có thể lặp lại n lần)

Random Deletion: remove ngẫu nhiên 1 từ trong câu với xác suất p (có thể lặp lại n lần)

Shuffle Sentences Transform: xáo trộn vị trí các câu trong văn bản

Exclude duplicate transform: xoá những câu bị trùng lặp trong văn bản

Synonym replacement via word-level embeddings thường hay được sử dụng và mang lại hiệu quả cao nhất

3.3.1.8. Data Generation#

có 4 phương pháp tiếp cận data generator phổ biến:

ImageDataGenerator: đơn giản + dễ áp dụng data augmentation, tuy nhiên load data chậm do sử dụng CPU thông qua generatorimage_dataset_from_directory: sẽ tạo đối tượng thuộc lớptf.data.Dataset(thay vì mộtgenerator), hiệu quả hơn với dữ liệu lớn, tốc độ xử lý cao hơngenerator.tf.data.Dataset: tạo dataset từ tensors, apply các transformations to data, hoạt động với bất kỳ loại datatype nào (tables, images, text,…), customize được cách import để đạt được hiệu quả tối đa (prefer using)TFRecords: một cấu trúc phức tạp vì biến đối data dưới dạng nhị phân và lưu vào 1/nhiều file TFRecords. Sử dụng TFRecords (thay vì image file) làm train time diễn ra nhanh hơn, đặc biệt cho dữ liệu lớn

# datasets: bộ dữ liệu sử dụng 10% dữ liệu train của 10-food-class-all

import os

data_folder = 'Datasets/10_food_classes_10_percent/'

data_folder = data_folder.strip(os.sep)

root_level = data_folder.count(os.sep)

for dirpath, dirnames, filenames in os.walk(data_folder):

dir_level = dirpath.count(os.sep)

print("|-----"*(dir_level - root_level), end = "")

print(dirpath.split(os.sep)[-1], end = ": ")

t = ""

if len(dirnames) > 0:

t+=f"{len(dirnames)} folders "

if len(filenames) > 0 :

t+=f"{len(filenames)} files "

print(t)

10_food_classes_10_percent: 2 folders 1 files

|-----test: 10 folders

|-----|-----ice_cream: 250 files

|-----|-----chicken_curry: 250 files

|-----|-----steak: 250 files

|-----|-----sushi: 250 files

|-----|-----chicken_wings: 250 files

|-----|-----grilled_salmon: 250 files

|-----|-----hamburger: 250 files

|-----|-----pizza: 250 files

|-----|-----ramen: 250 files

|-----|-----fried_rice: 250 files

|-----train: 10 folders

|-----|-----ice_cream: 75 files

|-----|-----chicken_curry: 75 files

|-----|-----steak: 75 files

|-----|-----sushi: 75 files

|-----|-----chicken_wings: 75 files

|-----|-----grilled_salmon: 75 files

|-----|-----hamburger: 75 files

|-----|-----pizza: 75 files

|-----|-----ramen: 75 files

|-----|-----fried_rice: 75 files

3.3.1.8.1. ImageDataGenerator#

Trong class ImageDataGenerator có các parameters cho việc áp dụng augmentation

directorylà folder mà mỗi class là 1 subfoder trong đó (labels được tạo từ subfolder names)

Dữ liệu được chia vào train và test directories và phân tách vào subfolders in each class.

Normalize the data: Dữ liệu ảnh thì mỗi giá trị color channel sẽ biến thiên trong khoảng [0, 255]. Để model train nhanh hơn và tăng performance, normalize cần phải được thực hiện để đưa các giá trị về [0,1]

Set the batch size: Thay vì train toàn bộ các ảnh cùng 1 lúc thì sẽ train theo batch. Thường lựa chọn batch_size = 32 vì nó thường hiệu quả trong nhiều TH khác nhau.

class_mode: cách label được return trong output

“categorical” will be 2D one-hot encoded labels,

“binary” will be 1D binary labels,

“sparse” will be 1D integer labels,

“input” will be images identical to input images (mainly used to work with autoencoders).

# data batch generator

import tensorflow as tf

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# set random seed

tf.random.set_seed(1)

train_data = ImageDataGenerator(rescale = 1/255)\

.flow_from_directory(

directory = data_folder + "/train", # data directory

batch_size = 32, # number of images to process at a time

target_size = (224,224), # convert all images to be 224 x 224

# (common size to balance the remain info and chi phí tính toán)

class_mode = 'binary', # cách label được return trong output

)

test_data = ImageDataGenerator(rescale = 1/255)\

.flow_from_directory(

directory = data_folder + "/test",

batch_size = 32,

target_size = (224,224),

class_mode = 'binary',

)

Found 1500 images belonging to 2 classes.

Found 500 images belonging to 2 classes.

3.3.1.8.2. image_dataset_from_directory#

Tuy nhiên ko có tuỳ chọn data augmentation, phải sử dụng data augmentation layer trong model

from tensorflow.keras.utils import image_dataset_from_directory

# Create training and test directories

train_dir = data_folder + "/train/"

test_dir = data_folder + "/test/"

IMG_SIZE = (224,224)

BATCH_SIZE = 32

train_data = image_dataset_from_directory(directory=train_dir,

image_size=IMG_SIZE,

label_mode="categorical",

batch_size=BATCH_SIZE,

shuffle = True)

test_data = image_dataset_from_directory(directory=test_dir,

image_size=IMG_SIZE,

label_mode="categorical",

shuffle = False)

3.3.1.8.3. tf.data.Dataset#

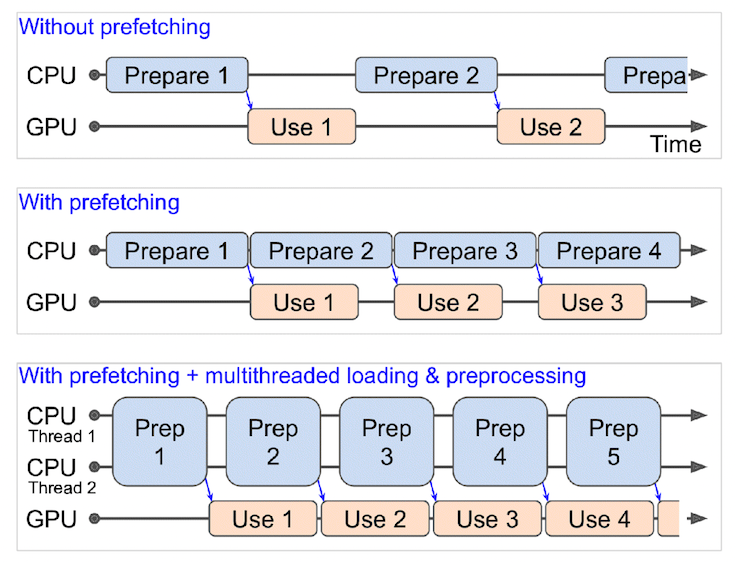

tạo dataset từ tensors, apply các transformations to data, hoạt động với bất kỳ loại datatype nào (tables, images, text,…), customize được cách import để đạt được hiệu quả tối đa (prefer using)

3.3.1.8.3.1. load data from tensorflow datasets#

import tensorflow_datasets as tfds

(train_data, test_data), ds_info = tfds.load(name="food101", # target dataset to get from TFDS

split=["train", "validation"], # what splits of data should we get? note: not all datasets have train, valid, test

shuffle_files=True, # shuffle files on download?

as_supervised=True, # download data in tuple format (sample, label), e.g. (image, label)

with_info=True) # include dataset metadata? if so, tfds.load() returns tuple (data, ds_info)

from glob import glob

import random

import os

def make_dataset(data, batch_size = 32, img_size = 224, shuffle = True):

def preprocess_img(image, label):

image = tf.image.resize(image, [img_size, img_size])

return tf.cast(image, tf.float32), label

def configure_for_performance(ds):

ds = ds.shuffle(buffer_size=1000)

ds = ds.batch(batch_size)

ds = ds.prefetch(buffer_size=tf.data.AUTOTUNE)

return ds

ds = data.map(preprocess_img, num_parallel_calls=tf.data.AUTOTUNE)

ds = configure_for_performance(ds)

return ds

train_data = make_dataset(train_data)

3.3.1.8.3.2. load data from local images#

Procedure:

Khởi tạo

tf.data.Datasetlà danh sách filenames vàmap()functionpreprocess_imgvào datasets, chức năng của function thực hiện read_file từ filename, decode ảnh, resize ảnh về target image, convert dtype vềfloat32.num_parallel_calls=tf.data.AUTOTUNEgiúp load nhiều ảnh song songkhông thể tạo batch tensors với các shapes khác nhau, đo đó phải resize ảnh về target image_size

Khởi tạo

tf.data.Datasetlà danh sách labelsZip data và labels thành 1

tf.data.DatasetConfigure dataset:

shuffle(): trộn data theo 1 bộ có size là buffer_size (from 1000 to 10000)Nếu

buffer_size > datasizetương đương với trộn trên toàn bộ dữ liệu, tuy nhiên sẽ ảnh hưởng đến performance vì phải load hết filenames của datasetNếu

buffer_size = 1, tương đương với việc ko shuffle dữ liệu

batch(): tạo batch dữ liệu theo tham số batch_sizeprefetch(): số lượng batches được preload trong khi 1 batch trước đó đang được computing, sử dụngtf.data.AUTOTUNEđể tự động tối ưu.cache(): sử dụng caches (lưu dữ liệu để sử dụng cho epoch tiếp theo) để tiết kiệm thời gian load cho lần chạy epoch tiếp theo, tuy nhiên chỉ sử dụng cache khi dữ liệu đủ nhỏ để fit được hết vào memory.

from glob import glob

import random

import os

import numpy as np

def make_dataset(path, batch_size = 32, img_size = 224, shuffle_size = 1000, label_encode = 'sparse'):

# shuffle_size = 1 mean not shuffle

def preprocess_img(filename):

image = tf.io.read_file(filename)

image = tf.image.decode_jpeg(image, channels=3)

image = tf.image.resize(image, [img_size, img_size])

return tf.cast(image, tf.float32)

def configure_for_performance(ds):

# ds = ds.cache()

ds = ds.shuffle(buffer_size=shuffle_size)

ds = ds.batch(batch_size)

ds = ds.prefetch(buffer_size=tf.data.AUTOTUNE)

return ds

filenames = glob(path + '/*/*')

random.shuffle(filenames)

if label_encode == 'sparse':

classes = os.listdir(path)

labels = [classes.index(name.split(os.sep)[-2]) for name in filenames]

elif label_encode == 'categorical':

classes = np.array(os.listdir(path))

labels = [(name.split(os.sep)[-2] == classes).astype(int) for name in filenames]

filenames_ds = tf.data.Dataset.from_tensor_slices(filenames)

images_ds = filenames_ds.map(preprocess_img, num_parallel_calls=tf.data.AUTOTUNE)

labels_ds = tf.data.Dataset.from_tensor_slices(labels)

ds = tf.data.Dataset.zip((images_ds, labels_ds))

ds = configure_for_performance(ds)

return ds

data_folder = "Datasets/10_food_classes_10_percent"

train_dir = data_folder + "/train/"

test_dir = data_folder + "/test/"

IMG_SIZE = 224

BATCH_SIZE = 32

train_data = make_dataset(train_dir, BATCH_SIZE, IMG_SIZE)

test_data = make_dataset(test_dir, BATCH_SIZE, IMG_SIZE,1) # set shuffle_size = 1 mean not shuffle for testset

train_data

<_PrefetchDataset element_spec=(TensorSpec(shape=(None, 224, 224, 3), dtype=tf.float32, name=None), TensorSpec(shape=(None,), dtype=tf.int32, name=None))>

len(train_data)

24

for img, label in test_data.take(1):

break

label

<tf.Tensor: shape=(32,), dtype=int32, numpy=

array([3, 5, 4, 5, 7, 6, 0, 8, 8, 7, 0, 4, 4, 1, 3, 0, 9, 5, 4, 8, 7, 5,

5, 4, 5, 3, 3, 4, 4, 2, 2, 0], dtype=int32)>

3.3.1.8.3.3. TFRecords#

Sử dụng TFRecords trong TH cần merge data thành 1/nhiều file hoặc sử dụng với TPUs, vì sử dụng GPUs + TFRecords ko có sự khác biệt về time performance so với local-files.

Sử dụng TFRecords + TPUs tăng đáng kể hiệu suất nhưng cũng giảm đôi chút sự chính xác của model. The drop in accuracy comes simply from the fact that different hyperparameter combinations are efficient with the TPUs but the tests used the same as the GPU. Using the right hyperparameters lead to similar accuracies than with the other methods.

3.3.1.8.3.3.1. Writing TFRecords#